Cách sửa lỗi Blocked by robots txt trong Google Search Console

Đánh giá

Các page xuất hiện trạng thái “Indexed, though blocked by robots.txt” hay “Blocked by robots txt” trong Google Search Console đều là những page bị ảnh hưởng và không được Google thu thập thông tin để lập chỉ mục. Tuy nhiên, giữa 2 trạng thái này lại có sự khác biệt nhất định mà bạn có thể tìm hiểu chi tiết qua bài viết sau.

Vai trò của file robots.txt trong quá trình lập chỉ mục

File robots.txt là gì?

File robots.txt đóng vai trò quan trọng và ảnh hưởng đến quá trình lập chỉ mục của page. Robots.txt là file được dùng với mục đích kiểm soát cách Googlebot thu thập dữ liệu về website. Khi thêm lệnh Disallow vào file, đồng nghĩa rằng Googlebot sẽ không thể truy cập vào các page áp dụng lệnh này.

Nguyên lý hoạt động giai đoạn khám phá, thu thập dữ liệu và lập chỉ mục

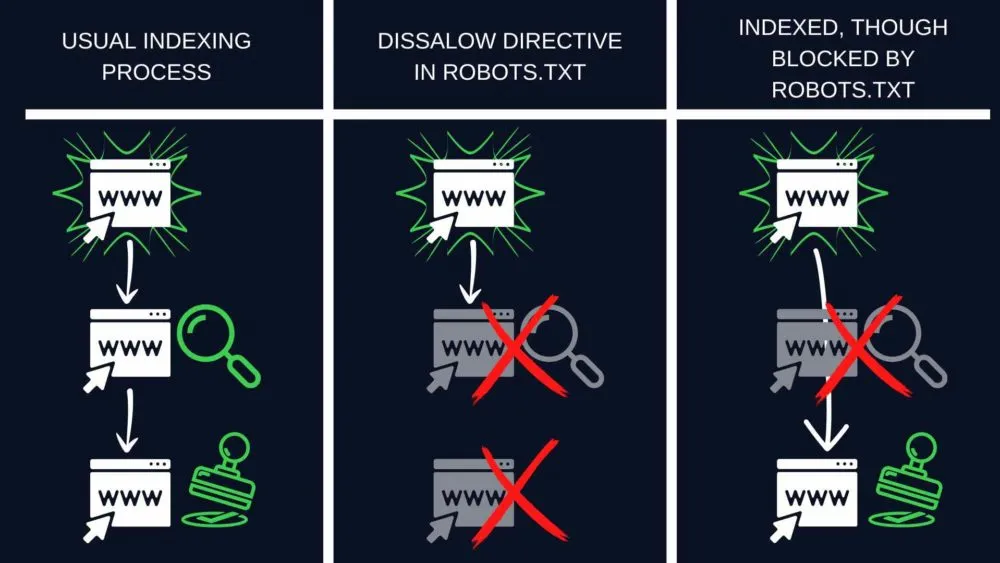

Để page được lập chỉ mục (index), trình thu thập thông tin của công cụ tìm kiếm đầu tiên cần khám phá và thu thập dữ liệu về page đó. Ở giai đoạn khám phá, trình thu thập thông tin sẽ biết rằng có tồn tại một URL cụ thể. Tới quá trình thu thập, Googlebot truy cập vào URL đó và thu thập dữ liệu nội dung. Lúc này, URL mới được lập chỉ mục và hiển thị trên kết quả tìm kiếm cùng với các kết quả khác.

Nguyên nhân gây lỗi “Indexed, though blocked by robots.txt” trong Google Search Console

Trong một số trường hợp, Google vẫn quyết định index cho một page đã được phát hiện nhưng không thể đọc hiểu nội dung hay thu thập dữ liệu trên trang. Trong trường hợp này, Google phần lớn bị thúc đẩy bởi các liên kết dẫn đến page bị chặn bởi file robots.txt. Các liên kết này được chuyển đổi thành điểm PageRank. Và Google sẽ tính toán dựa trên số điểm này để đánh giá một page cụ thể có quan trọng hay không. Thuật toán PageRank xem xét cả internal links và external links.

Nếu Google nhận thấy một page bị chặn có điểm PageRank cao, nó có thể nhận định rằng page đó đủ quan trọng để được index. Tuy nhiên, chỉ mục sẽ chỉ lưu trữ một URL trống thông tin vì nội dung chưa được thu thập dữ liệu.

Vì sao lỗi “Indexed, though blocked by robots.txt” ảnh hưởng đến SEO?

Trạng thái “Indexed, though blocked by robots.txt” là vấn đề nghiêm trọng. Có vẻ như tình trạng này không gây hại, nhưng thực tế lại có thể phá hỏng chiến lược SEO trên website của bạn theo 2 cách:

Giao diện tìm kiếm kém

Nếu bạn vô tình chặn một page thì trạng thái “Indexed, though blocked by robots.txt” không có nghĩa là Google đã sửa lỗi cho bạn. Đối với các page được lập chỉ mục nhưng không thu thập dữ liệu sẽ có giao diện hiển thị kém hấp dẫn hơn trong kết quả tìm kiếm. Điều này là do Google không thể hiển thị các yếu tố quan trọng:

- Thẻ tiêu đề (thay vào đó là sẽ tự động tạo tiêu đề từ URL hoặc thông tin được cung cấp bởi các page liên kết dẫn đến page của bạn).

- Meta description.

- Bất kỳ thông tin bổ sung nào dưới dạng kết quả nhiều định dạng.

Nếu thiếu các yếu tố này, người dùng sẽ không biết được điều gì sẽ xảy ra sau khi truy cập vào page. Họ có thể lựa chọn các website cạnh tranh khác và làm giảm đáng kể tỷ lệ nhấp chuột (CTR) của bạn.

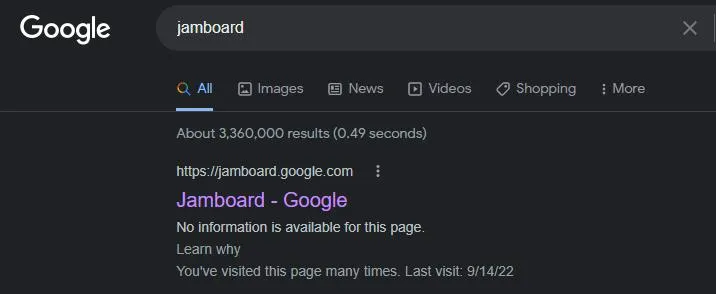

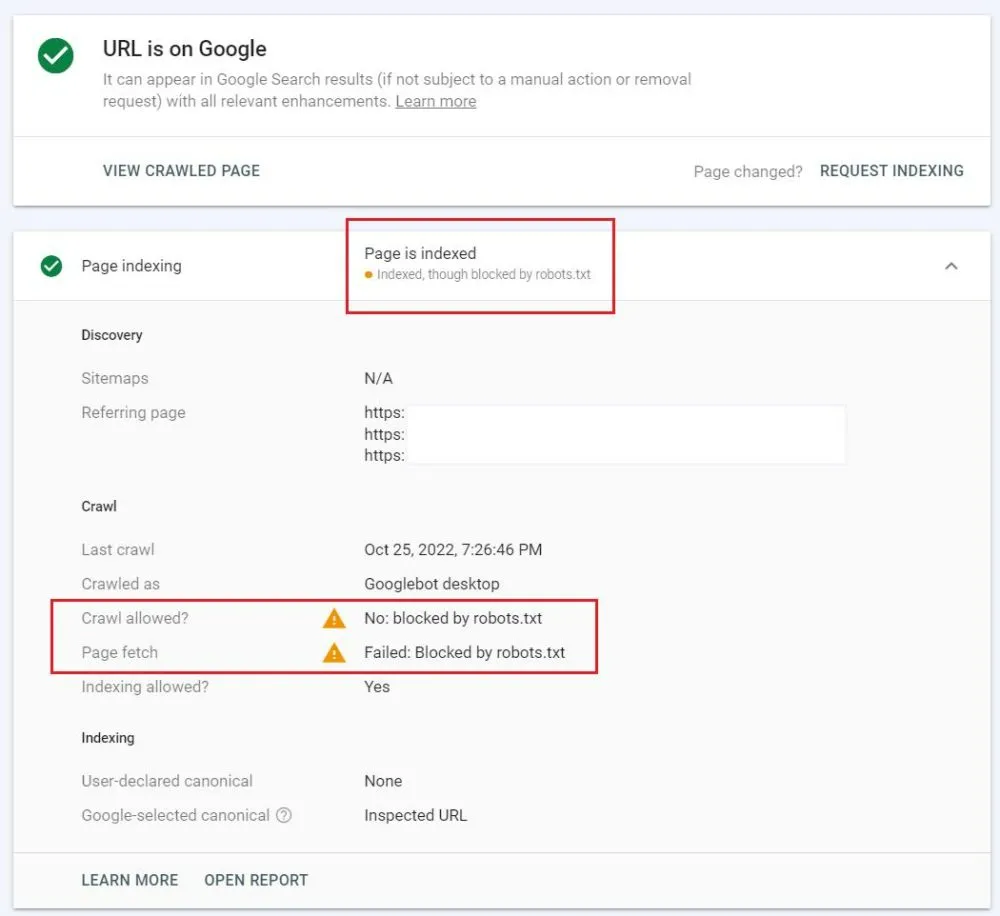

Ví dụ:

Google Jamboard gặp tình trạng “Indexed, though blocked by robots.txt” – bị chặn thu thập thông tin nhưng nhờ gần 20.000 liên kết được dẫn từ các website khác (theo Ahrefs) mà website này vẫn được Google lập chỉ mục.

Do đó, dù page được xếp hạng trên bảng hiển thị kết quả tìm kiếm, thế nhưng Google Jamboard lại hiển thị mà không chứa bất kỳ thông tin bổ sung nào. Lý giải cho điều này là vì Google không thể thu thập dữ liệu hay bất kỳ thông tin nào khác. Thay vào đó, bot tìm kiếm chỉ có thể hiển thị URL và tiêu đề cơ bản dựa trên những gì được tìm thấy ở những website liên kết với Jamboard.

Lưu lượng truy cập không mong muốn

Nếu cố tình sử dụng lệnh Disallow trong file robots.txt cho một page cụ thể, đồng nghĩa rằng bạn không muốn người dùng tìm thấy page đó trên Google. Chẳng hạn như, bạn vẫn đang chỉnh sửa nội dung của page và chưa sẵn sàng để hiển thị công khai. Lúc này, nếu page được lập chỉ mục, người dùng có thể tìm thấy, truy cập và đưa ra ý kiến tiêu cực về website.

Cách khắc phục “Indexed, though blocked by robots.txt”

Quá trình sửa lỗi “Indexed, though blocked by robots.txt” diễn ra như sau:

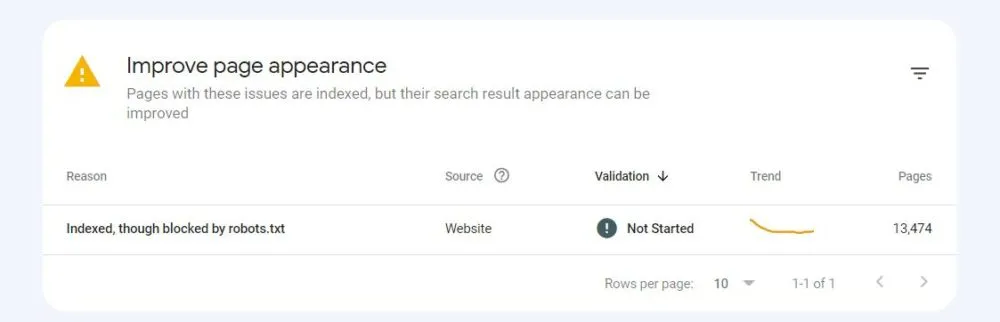

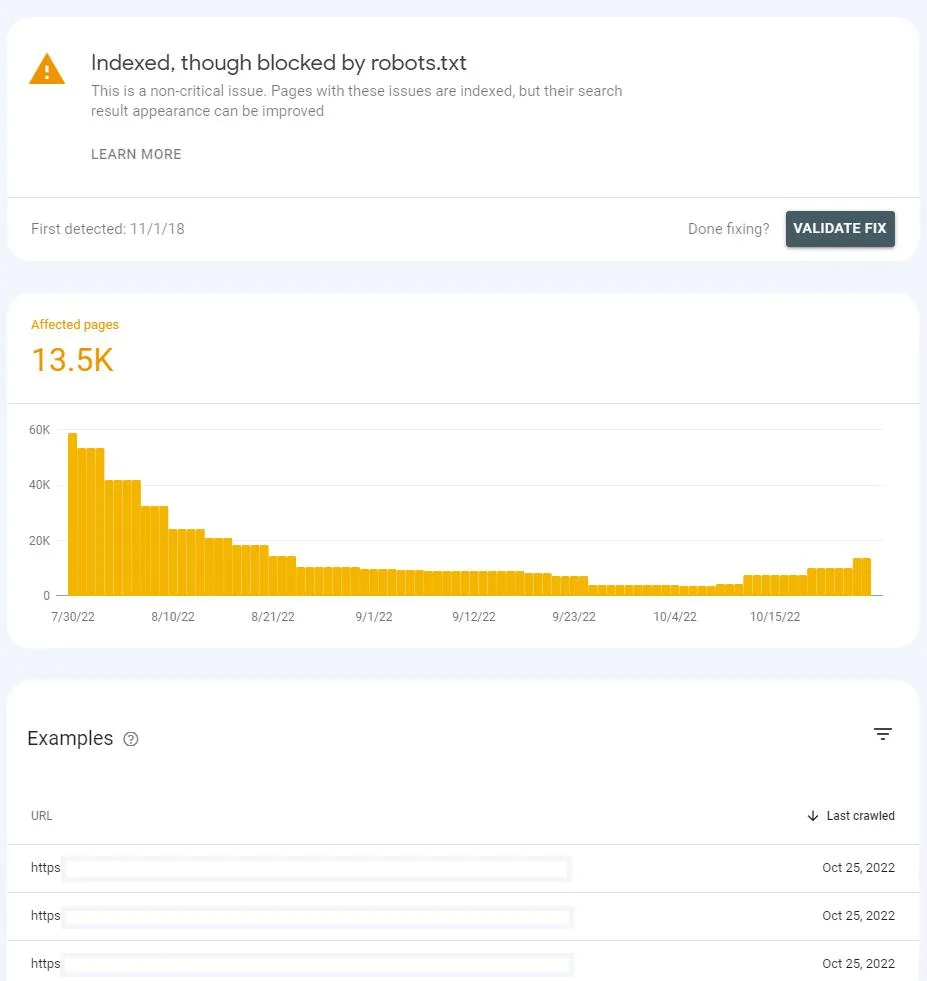

Bước 1: Hãy tìm trạng thái “Indexed, though blocked by robots.txt” ở cuối báo cáo Page Index trong Google Search Console. Tại đây, bạn có thể thấy bảng “Improve page appearance”.

Bước 2: Nhấp vào trạng thái để hiển thị danh sách các URL bị ảnh hưởng và biểu đồ cho biết số lượng URL đã thay đổi theo thời gian.

Để tiếp tục, bạn cần đánh giá xem các URL trong danh sách có thực sự nên được index không? Hãy xem những URL này có mang tới nội dung hữu ích nào cho người dùng truy cập. Sau đó:

Trường hợp muốn page được lập chỉ mục

Nếu page bị chặn trong file robots.txt do nhầm lẫn, bạn chỉnh sửa lại file để loại bỏ lệnh Disallow. Sau khi loại bỏ lệnh Disallow, Googlebot có thể sẽ thu thập dữ liệu và lập chỉ mục cho URL đó vào lần truy cập tiếp theo trên website.

Trường hợp muốn page được deindex

Nếu page chứa thông tin không muốn hiển thị cho người dùng khi họ truy cập từ công cụ tìm kiếm, bạn cần thông báo cho Google biết rằng page đó không cần được lập chỉ mục. Không nên sử dụng file robots.txt để kiểm soát quá trình lập chỉ mục. Bởi vì file này sẽ ngăn chặn Google thu thập dữ liệu page. Thay vào đó, biện pháp mà bạn nên áp dụng là dùng noindex tag.

Google luôn tuân thủ lệnh từ thẻ noindex mỗi khi thấy thẻ hiển thị trên page. Bằng cách áp dụng lệnh này, bạn có thể đảm bảo rằng, page sẽ không được Google hiển thị trong kết quả tìm kiếm.

Đặc biệt, hãy cho phép Google thu thập dữ liệu page để khám phá thẻ HTML này. Đây là một phần nội dung của page, cung cấp chỉ dẫn để Google không lập chỉ mục page. Nếu thêm thẻ noindex nhưng vẫn chặn page trong file robots.txt, Google sẽ không phát hiện ra thẻ này. Như vậy, page đó vẫn duy trì trạng thái “Indexed, though blocked by robots.txt”.

Khi Google thu thập dữ liệu page và phát hiện ra thẻ noindex, Google sẽ loại bỏ page đó ra khỏi danh sách kết quả tìm kiếm. Qua đó, Google Search Console sẽ hiển thị trạng thái chỉ mục khác khi kiểm tra URL đó.

Trường hợp cần giải pháp dài hạn

Các giải pháp được đề cập ở trên chỉ giúp tình trạng “Indexed, though blocked by robots.txt” được khắc phục trong một thời gian. Trong nhiều trường hợp, tình trạng này có thể xuất hiện ở các page khác của website trong tương lai. Trạng thái như vậy cho thấy website cần tiến hành kiểm tra và cải thiện về internal link hoặc backlink.

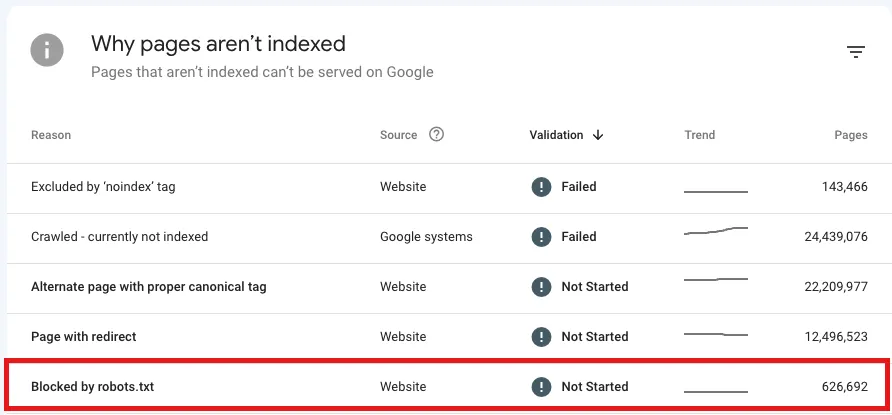

Lỗi “Blocked by robots.txt” trong Google Search Console

Trạng thái “Blocked by robots.txt” cho biết URL không được Google thu thập dữ liệu vì đã bị chặn bởi lệnh Disallow trong file robots.txt. Điều này đồng nghĩa rằng URL đó không được lập chỉ mục.

Trong quá trình phát triển website, việc chặn Google thu thập dữ liệu đối với một số URL là điều bình thường, đặc biệt là khi website đang ngày càng lớn dần. Việc quyết định xem page nào nên và không nên được thu thập dữ liệu trên website là một bước quan trọng trong chiến lược lập chỉ mục phù hợp cho website.

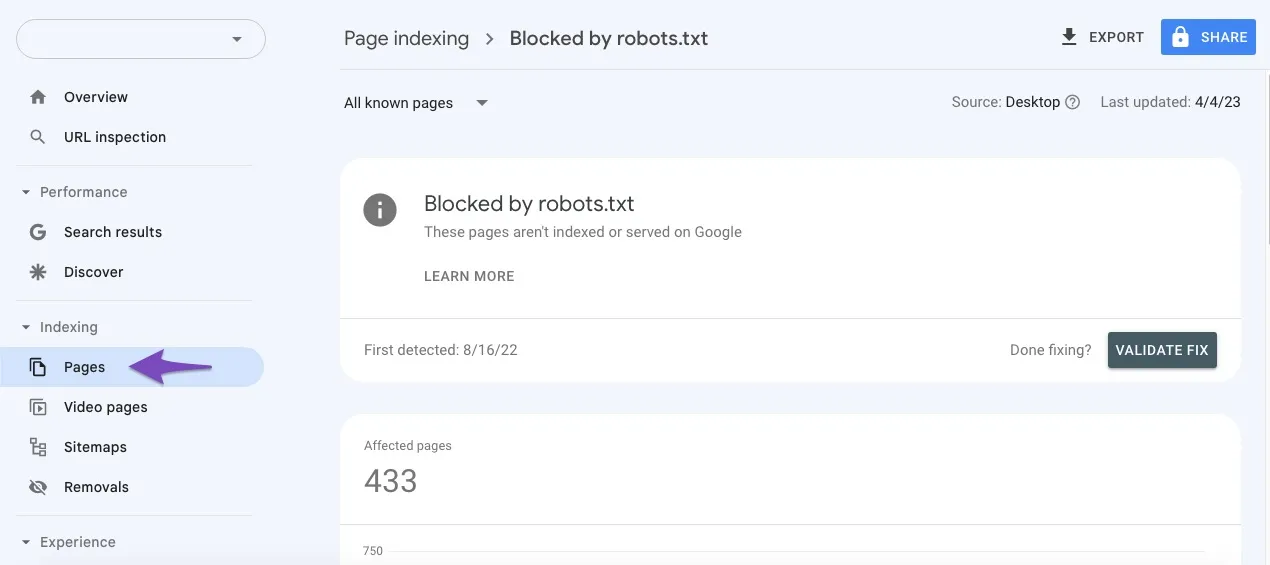

Khắc phục lỗi “Blocked by robots.txt”

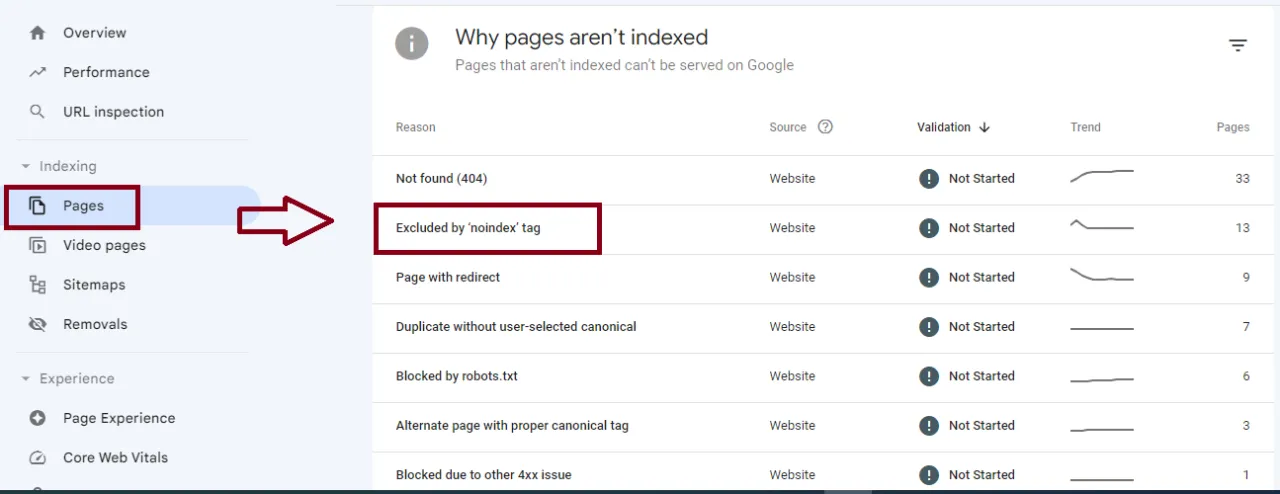

Để loại bỏ trạng thái “Blocked by robots.txt”, bạn cần tiến hành di chuyển đến bảng “Why pages aren’t indexed” nằm bên dưới biểu đồ trong báo cáo Page Index để điều hướng trạng thái Blocked by robots.txt issues.

Quá trình giải quyết trạng thái này sẽ dựa vào việc page bị chặn do nhầm lẫn hay cố ý. Cụ thể:

Trường hợp vô tình sử dụng lệnh Disallow

Ở trường hợp này, để khắc phục lỗi “Blocked by robots.txt”, hãy loại bỏ lệnh Disallow cho URL cụ thể mà bạn muốn Googlebot thu thập dữ liệu và lập chỉ mục trong file robots.txt. Sau đó, Googlebot có thể truy cập và thu thập dữ liệu URL ở lần tiếp theo. Nếu không phát sinh thêm vấn đề khác, Google sẽ tiến hành lập chỉ mục URL đó.

Ngược lại, nếu có nhiều URL bị ảnh hưởng bởi sự cố này, bạn có thể sử dụng Google Search Console để khắc phục bằng cách:

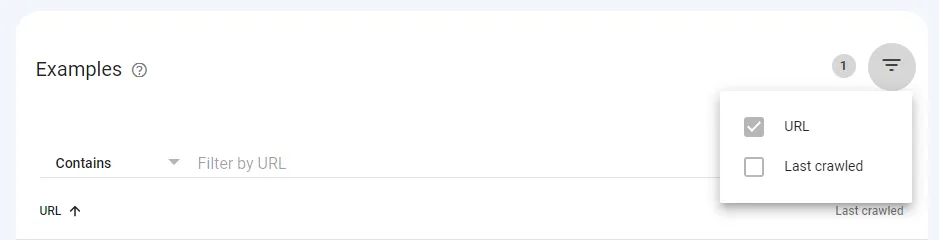

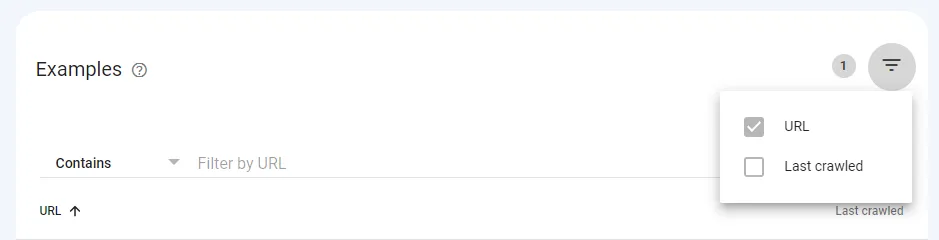

Bước 1: Nhấp vào trạng thái và chọn biểu tượng kim tự tháp ngược ở phía trên danh sách URL.

Bước 2: Lọc tất cả page bị ảnh hưởng theo URL (hoặc một phần của URL) hoặc theo ngày thu thập dữ liệu gần nhất.

Nếu xuất hiện trạng thái “Blocked by robots.txt” thì có thể là bạn đã cố tình thiết lập chặn toàn bộ thư mục và thư mục đó có chứa page muốn được index. Để khắc phục, bạn có thể:

- Sử dụng càng nhiều đoạn đường dẫn URL trong lệnh Disallow càng tốt nhằm hạn chế các lỗi có thể xảy ra.

- Sử dụng lệnh Allow cho phép bot thu thập dữ liệu một URL cụ thể trong thư mục bị chặn.

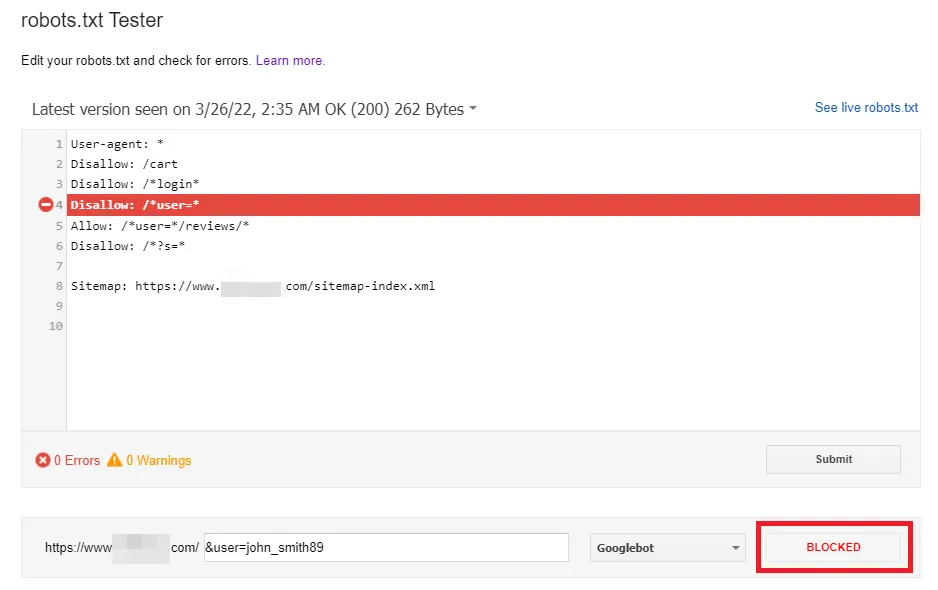

Ngoài ra, công cụ robots.txt Tester còn cho phép kiểm tra mức độ ảnh hưởng của các lệnh đến một URL cụ thể trên tên miền với User-agent, chẳng hạn như Googlebot. Nhờ điều này, bạn có thể thử nghiệm cách áp dụng các lệnh khác nhau và quan sát URL đó có bị chặn hay không.

Tuy nhiên, công cụ sẽ không tự động thay đổi file robots.txt. Do đó, khi quá trình kiểm tra các lệnh hoàn tất, bạn cần thực hiện điều chỉnh file một cách thủ công đối với tất cả các thay đổi.

Ngoài ra, tiện ích mở rộng Robots Exclusion Checker trong Google Chrome cũng là lựa chọn phù hợp trong trường hợp cần duyệt bất kỳ tên miền nào bị chặn bởi file robots.txt. Công cụ này hoạt động theo thời gian thực nên có thể giúp bạn kiểm tra và xử lý các URL bị chặn trên tên miền nhanh chóng nhất.

Trường hợp cố tình sử dụng lệnh Disallow

Bạn có thể bỏ qua trạng thái “Blocked by robots.txt” trong Google Search Console miễn là không có bất kỳ URL nào bị chặn trong file robots.txt. Việc chặn bot tìm kiếm thu thập nội dung trùng lặp hoặc có chất lượng thấp trên page là điều hoàn toàn bình thường. Việc quyết định page nào nên hay không nên được bot tìm kiếm thu thập dữ liệu lại là điều quan trọng để:

- Xây dựng chiến lược thu thập dữ liệu cho website.

- Tối ưu hóa và tiết kiệm ngân sách thu thập dữ liệu.

Lời kết

Trên đây là những thông tin về tầm quan trọng của file robots.txt, cũng như nguyên nhân và cách khắc phục lỗi “Blocked by robots txt” và “Indexed, though blocked by robots.txt” trong Google Search Console. Hy vọng bài viết sẽ giúp bạn hiểu và khắc phục các lỗi này thành công không gây ảnh hưởng tới kết quả hiển thị trên các công cụ tìm kiếm.

THEO DÕI VÀ CẬP NHẬT CHỦ ĐỀ BẠN QUAN TÂM

Đăng ký ngay để nhận những thông tin mới nhất từ blog của chúng tôi. Đừng bỏ lỡ cơ hội truy cập kiến thức và tin tức hàng ngày