LangChain là gì? Tìm hiểu vai trò của nền tảng LangChain trong lập trình AI

Đã kiểm duyệt nội dung

Đánh giá

LangChain là framework mã nguồn mở hỗ trợ xây dựng các ứng dụng AI dựa trên mô hình ngôn ngữ lớn thông qua việc kết nối prompt, dữ liệu và logic xử lý thành các chuỗi linh hoạt. Nền tảng này giúp lập trình viên dễ dàng phát triển AI agent, chatbot và hệ thống AI có khả năng suy luận, ghi nhớ và tương tác với nhiều nguồn dữ liệu khác nhau. Trong bài viết này, mình sẽ cùng bạn tìm hiểu tổng quan về LangChain bao gồm vai trò của LangChain trong lập trình AI và cách nền tảng này được ứng dụng trong thực tế.

Những điểm chính

- Khái niệm: Hiểu rõ LangChain là framework này LLM kết nối với dữ liệu thực tế để trở thành các Agent thông minh.

- Lợi ích ứng dụng: Nắm bắt các giá trị vượt trội của LangChain giúp đơn giản hóa quy trình phát triển, tiết kiệm chi phí và tăng tính cá nhân hóa cho AI.

- Cấu trúc và module: Hiểu sâu vai trò của các thành phần như model I/O, prompts, memory để xây dựng ứng dụng AI chuyên nghiệp và logic.

- Công cụ giám sát mở rộng: Biết cách sử dụng LangGraph và LangSmith để điều phối đa tác tử và tối ưu hóa hiệu năng hệ thống chuyên sâu.

- Cơ chế hoạt động: Nắm vững nguyên lý trừu tượng hóa và quy trình thực thi liên kết giúp vận hành luồng dữ liệu AI tự động và nhất quán.

- Ứng dụng thực tế doanh nghiệp: Khám phá các giải pháp chatbot, trợ lý ảo và trích xuất dữ liệu giúp nâng cao năng suất lao động và tự động hóa quy trình.

- Biết thêm Vietnix là nhà cung cấp dịch vụ VPS và cloud tối ưu dành cho doanh nghiệp.

- Câu hỏi thường gặp: Giải đáp các thắc mắc thường gặp liên quan đến LangChain.

LangChain là gì?

LangChain là một framework mã nguồn mở được thiết kế chuyên biệt để hỗ trợ các developer xây dựng ứng dụng tích hợp mô hình ngôn ngữ lớn (LLM). Framework này hỗ trợ hai ngôn ngữ lập trình phổ biến nhất hiện nay là Python và JavaScript, cho phép kết nối linh hoạt giữa sức mạnh tính toán của AI với các nguồn dữ liệu ngoại vi.

Được Harrison Chase ra mắt vào tháng 10 năm 2022, LangChain đã ghi nhận tốc độ phát triển nhanh chóng trên Github. Nền tảng này không thay thế các mô hình AI có sẵn mà còn đóng vai trò kết nối, giúp đơn giản hóa quy trình tích hợp và mở rộng khả năng của các mô hình như GPT-4 hay Claude vào trong các phần mềm phức tạp. Mục tiêu quan trọng nhất của framework này là giải quyết các hạn chế của LLM, chẳng hạn như:

- Cập nhật dữ liệu thời gian thực: LLM thường có dữ liệu bị giới hạn tại một thời điểm trong quá khứ. Trong khi đó LangChain cung cấp công cụ để mô hình truy cập vào các nguồn dữ liệu mới nhất từ Internet hoặc cơ sở dữ liệu nội bộ.

- Tăng độ chính xác: Thông qua việc tùy chỉnh lời nhắc và kiểm soát luồng thông tin, LangChain giúp giảm tình trạng AI đưa ra thông tin sai lệch.

- Cá nhân hóa ngữ cảnh: Framework này giúp mô hình hiểu sâu hơn về dữ liệu riêng biệt của từng doanh nghiệp, từ đó đưa ra câu trả lời mang tính ứng dụng thực tiễn cao hơn.

Khi ứng dụng LangChain vào các dự án lập trình AI, môi trường triển khai cần đảm bảo hiệu năng xử lý, tốc độ truy xuất dữ liệu và khả năng mở rộng linh hoạt. Với VPS NVMe của Vietnix, bạn có thể xây dựng và vận hành các ứng dụng AI sử dụng LangChain trên hạ tầng tối ưu về I/O, giúp mô hình và pipeline xử lý hoạt động ổn định, đáp ứng tốt nhu cầu phát triển và thử nghiệm trong thực tế. Liên hệ ngay để được tư vấn chi tiết về dịch vụ!

Lợi ích của LangChain trong phát triển phần mềm

LangChain mang lại nhiều giá trị thiết thực cho doanh nghiệp cũng như lập trình viên trong quá trình xây dựng ứng dụng AI, thể hiện rõ qua các khía cạnh sau đây:

1. Đơn giản hóa quy trình phát triển AI

Ưu điểm lớn nhất của LangChain là khả năng trừu tượng hóa các quy trình phức tạp. Thay vì phải tự viết các đoạn code dài dòng để kết nối dữ liệu, phân tích ngữ nghĩa hay tinh chỉnh prompt, lập trình viên có thể tận dụng các module đã được cấu trúc sẵn của framework. Nhờ vậy, đội ngũ phát triển có thể tập trung tối đa vào việc xây dựng logic nghiệp vụ và trải nghiệm người dùng.

Bên cạnh đó, LangChain cung cấp sự linh hoạt tuyệt đối trong việc lựa chọn công nghệ. Doanh nghiệp có thể dễ dàng thay thế hoặc so sánh hiệu năng giữa các mô hình khác nhau với mức thay đổi mã nguồn thấp nhất. Khả năng này giúp các dự án phần mềm không bị phụ thuộc vào một nhà cung cấp LLM duy nhất.

2. Khả năng tái sử dụng và mở rộng mô hình

Đào tạo lại một mô hình ngôn ngữ lớn để phục vụ cho một lĩnh vực cụ thể gây tiêu tốn nguồn lực tài chính và hạ tầng vô cùng lớn. LangChain cung cấp giải pháp thay thế thông minh hơn bằng cách hỗ trợ tái sử dụng các LLM có sẵn và bổ sung thêm kiến thức chuyên môn vào mô hình thông qua ngữ cảnh.

Bằng cách kết nối trực tiếp LLM với cơ sở dữ liệu nội bộ, tài liệu pháp lý hay dữ liệu khách hàng của doanh nghiệp, LangChain đảm bảo AI chỉ sử dụng các thông tin chính xác được cung cấp để đưa ra câu trả lời. Quy trình này mở rộng năng lực của mô hình và giảm tối đa tình trạng AI tự tạo ra thông tin sai lệch khi không có đủ dữ liệu nền.

3. Cộng đồng hỗ trợ mạnh mẽ và hạ tầng triển khai linh hoạt

Là dự án mã nguồn mở miễn phí, LangChain sở hữu cộng đồng phát triển lớn. Bạn có thể dễ dàng tìm thấy tài liệu hướng dẫn, các đoạn code mẫu và các công cụ tích hợp cho mọi nhu cầu. Hơn nữa, hệ sinh thái này còn tương thích hoàn hảo với các nền tảng công nghệ lớn trên thế giới như AWS, IBM watsonx. Tại Việt Nam, các doanh nghiệp thường lựa chọn triển khai các ứng dụng chạy trên nền tảng LangChain lên hệ thống Cloud Server hoặc VPS để tận dụng tối đa băng thông đường truyền trong nước và khả năng xử lý tốc độ cao của ổ cứng NVMe.

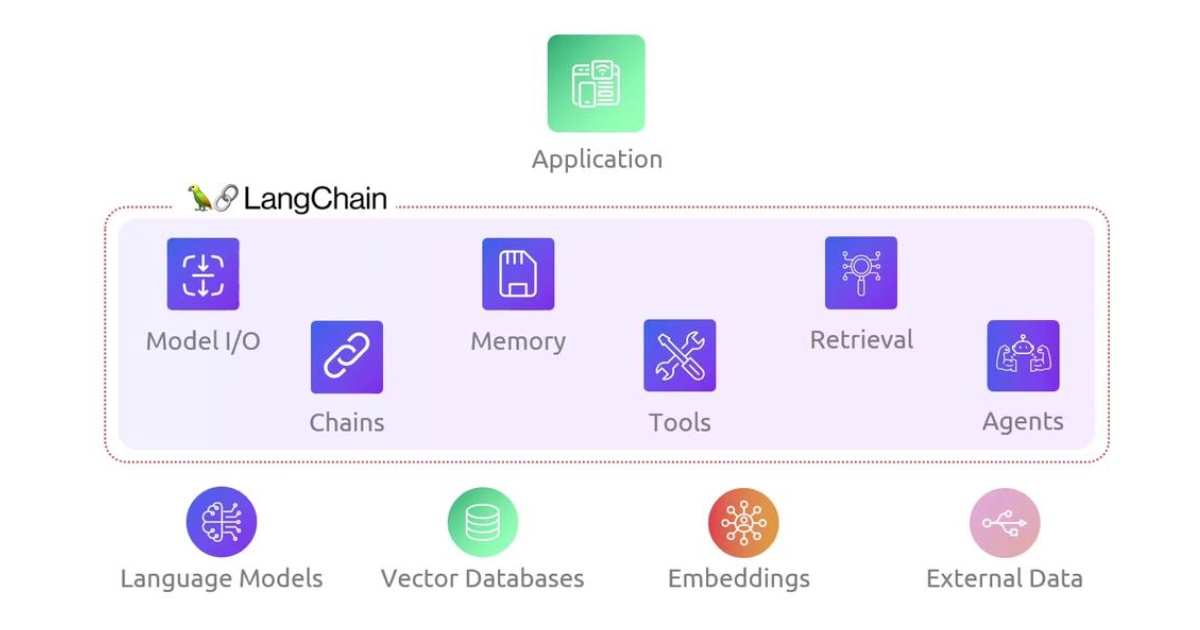

Cấu trúc kỹ thuật của LangChain

1. Model I/O

Đây là lớp module đầu tiên đóng vai trò làm cầu nối giữa ứng dụng và các mô hình ngôn ngữ lớn. LangChain cung cấp một giao diện chuẩn hóa để kết nối với hàng trăm LLM từ nhiều nhà cung cấp khác nhau như OpenAI, Anthropic hay các mô hình chạy cục bộ thông qua Ollama.

Trong module này, framework phân chia thành hai loại chính bao gồm: LLM dành cho các mô hình dự đoán văn bản cơ bản và ChatModel dành cho các ứng dụng hội thoại dựa trên tin nhắn. Việc chuẩn hóa này giúp lập trình viên có thể thay đổi model của website AI nhanh chóng mà không cần thay đổi cấu trúc mã nguồn phức tạp bên dưới.

2. Prompts

Thay vì gửi các yêu cầu văn bản rời rạc, LangChain sử dụng PromptTemplate để cấu trúc hóa đầu vào cho mô hình. Lớp module này cho phép tạo ra các lời nhắc động bằng cách chèn các biến số linh hoạt vào trong một framework có sẵn.

Việc quản lý lời nhắc theo cách này giúp tái sử dụng các mẫu câu lệnh hiệu quả cho nhiều ứng dụng khác nhau. Điều này đặc biệt quan trọng trong việc duy trì sự nhất quán về phong cách phản hồi của AI và tối ưu hóa chi phí token khi giao tiếp với các API của nhà cung cấp.

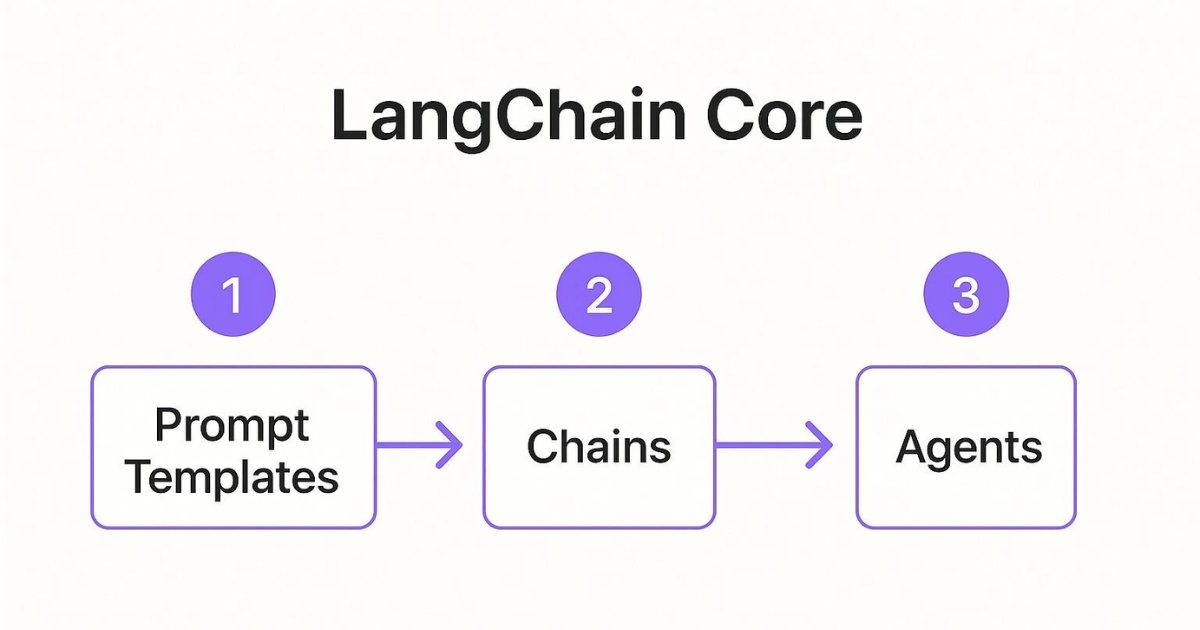

3. Chains

Chains cho phép kết nối nhiều thành phần AI hoặc nhiều bước xử lý thành một quy trình tự động hoàn chỉnh từ khâu tiếp nhận đầu vào đến khi trả về đầu ra. Một số loại chuỗi phổ biến bao gồm:

- LLM Chain: Chuỗi đơn giản nhất kết hợp một mô hình ngôn ngữ và một mẫu lời nhắc.

- Sequential Chain: Chuỗi tuần tự, nơi đầu ra của bước trước sẽ trở thành đầu vào cho bước sau.

- Router Chain: Chuỗi định tuyến có khả năng phân tích dữ liệu đầu vào để quyết định chuyển tiếp yêu cầu đến các nhánh xử lý phù hợp nhất.

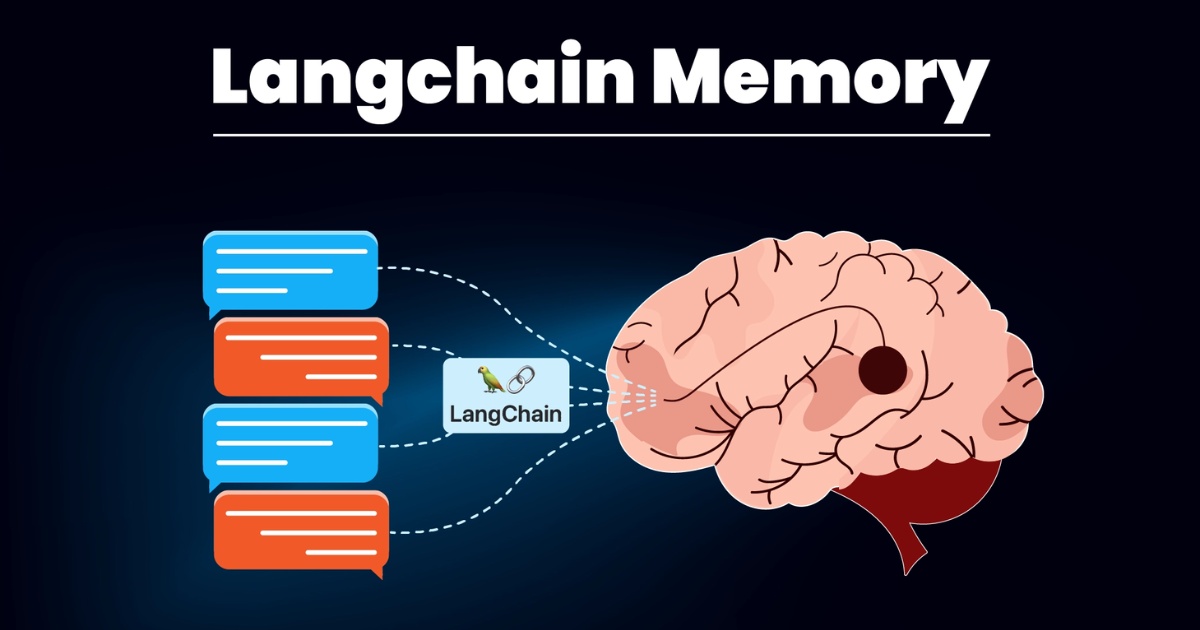

4. Memory

Mặc định, các mô hình ngôn ngữ lớn hoạt động theo cơ chế không lưu trạng thái, nghĩa là chúng không thể nhớ những gì đã trao đổi trước đó. LangChain giải quyết vấn đề này bằng module Memory, giúp website AI ghi nhớ lịch sử tương tác để duy trì ngữ cảnh xuyên suốt cuộc hội thoại. Tùy vào nhu cầu tài nguyên, bạn có thể lựa chọn các loại bộ nhớ như:

- Buffer Memory: Lưu trữ toàn bộ lịch sử trò chuyện.

- Buffer Window Memory: Chỉ lưu trữ một số lượng tin nhắn gần nhất để tối ưu dung lượng.

- Conversation Summary Memory: Sử dụng chính LLM để tóm tắt lại nội dung cuộc đối thoại, giúp tiết kiệm bộ nhớ mà vẫn giữ được các ý chính quan trọng.

5. Retrieval và Indexes

Đây là module được sử dụng để xây dựng các ứng dụng RAG, cho phép AI sử dụng dữ liệu riêng của doanh nghiệp. Quy trình này bao gồm các thành phần như:

- Document Loaders: Hỗ trợ tải dữ liệu từ đa dạng nguồn như Github, Google Drive hoặc các file văn bản chuyên dụng.

- Text Splitters: Chia nhỏ các tài liệu khổng lồ thành các đoạn văn có ý nghĩa để AI dễ dàng xử lý.

- Vector Stores và Embeddings: Chuyển đổi văn bản sang dạng vector toán học và lưu trữ trong các cơ sở dữ liệu vector. Khi người dùng đặt câu hỏi, hệ thống sẽ tìm kiếm các đoạn văn có ngữ nghĩa gần nhất để cung cấp làm ngữ cảnh cho LLM.

6. Agents

Khác với chuỗi xử lý được lập trình sẵn các bước, Agent đóng vai trò như một trợ lý có khả năng suy luận và tự quyết định trình tự hành động. Dựa trên yêu cầu của người dùng, Agent sẽ tự đánh giá xem cần sử dụng công cụ nào để hoàn thành tác vụ. Hoạt động của Agent diễn ra theo vòng lặp logic – Suy nghĩ để lập kế hoạch, sau đó hành động bằng cách gọi công cụ, tiếp đến là quan sát kết quả trả về. Vòng lặp này giúp AI có thể xử lý các bài toán phức tạp đòi hỏi sự linh hoạt cao.

7. Tools và Output Parsers

Để Agent có thể tương tác với thế giới bên ngoài, LangChain cung cấp hệ thống Tools đa dạng như công cụ tìm kiếm Google, Wikipedia, máy tính hoặc các API tùy chỉnh. Hệ thống này giúp AI trả lời văn bản và có thể thực hiện các hành động thực tế.

Sau khi mô hình đưa ra phản hồi, Output Parsers sẽ đảm nhận nhiệm vụ định dạng lại kết quả. Thay vì nhận về một đoạn văn thuần túy, bạn có thể yêu cầu AI trả về dữ liệu dưới dạng cấu trúc như JSON hoặc CSV để tích hợp trực tiếp vào cơ sở dữ liệu của website doanh nghiệp.

Các công cụ mở rộng hỗ trợ giám sát và điều phối

1. LangGraph

LangGraph là framework mở rộng được xây dựng trên nền tảng LangChain. Nó cho phép người dùng thiết kế các luồng công việc có tính trạng thái (stateful) và sở hữu khả năng chịu lỗi cao. Khác với các chuỗi xử lý thông thường chỉ đi theo một hướng từ đầu vào đến đầu ra, LangGraph hỗ trợ tạo ra các quy trình có vòng lặp.

Ưu thế lớn nhất của LangGraph là khả năng điều phối đa tác tử. Website doanh nghiệp có thể sở hữu nhiều Agent khác nhau. Mỗi Agent đảm nhận một chuyên môn riêng và LangGraph đóng vai trò điều phối các Agent này tương tác, cộng tác và trao đổi thông tin với nhau để hoàn thành các mục tiêu phức tạp mà một mô hình đơn lẻ khó có thể thực hiện tốt.

2. LangSmith

LangSmith là công cụ chuyên dụng cung cấp khả năng giám sát, đánh giá và gỡ lỗi chuyên sâu. Thông qua giao diện quản lý của LangSmith, bạn có thể theo dõi chi tiết từng bước trong quy trình xử lý của LLM, từ đó xác định rõ độ trễ và chi phí token tiêu tốn cho mỗi yêu cầu. Khả năng truy vết mạnh mẽ của công cụ này cũng giúp tìm ra nguyên nhân gây lỗi hoặc các thành phần làm sụt giảm hiệu năng nhanh chóng

Hiểu rõ cơ chế vận hành của LangChain giúp các nhà phát triển tối ưu hóa được luồng dữ liệu và xây dựng những ứng dụng AI có độ phản hồi nhanh, chính xác. Framework này không chỉ đơn thuần là một thư viện kết nối mà là một hệ thống điều phối thông minh dựa trên các nguyên lý lập trình hiện đại.

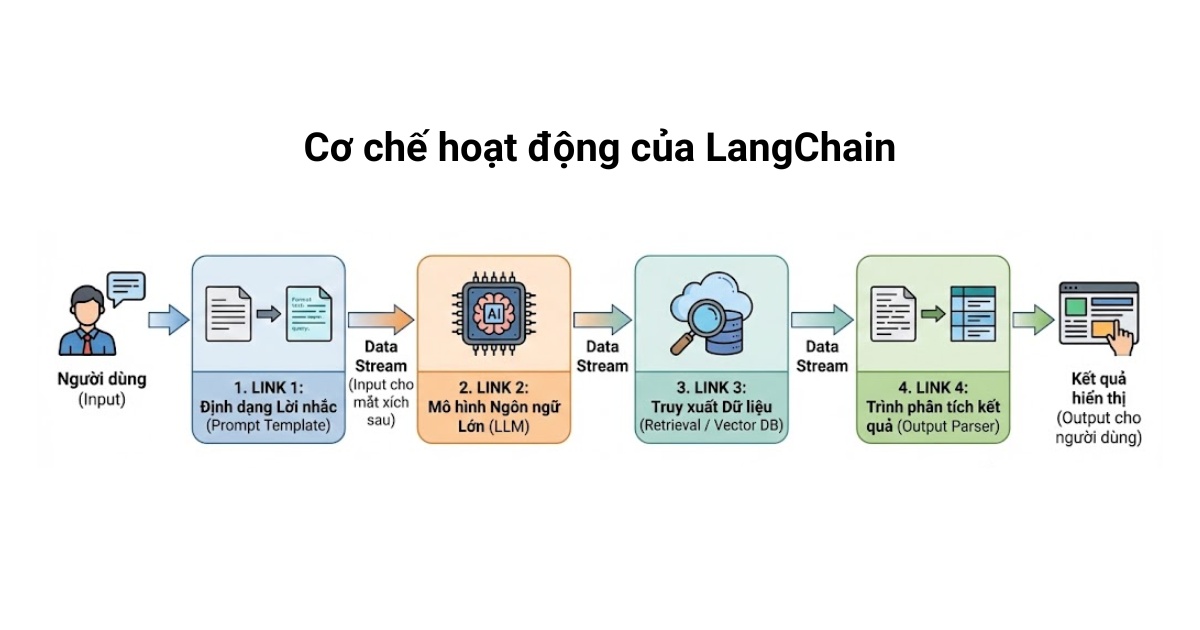

Cơ chế hoạt động của LangChain

LangChain có khả năng ứng dụng nguyên lý trừu tượng hóa, biểu diễn các quy trình kỹ thuật phức tạp từ việc định dạng lời nhắc, gọi API đến xử lý kết quả thành các thành phần được đặt tên rõ ràng dưới dạng các lớp đối tượng hoặc hàm. Nhờ vậy, bạn không cần phải quan tâm sâu đến mã nguồn bên dưới của từng mô hình ngôn ngữ hay cấu trúc API riêng biệt của từng nhà cung cấp mà chỉ cần tập trung vào việc lắp ghép các module chức năng để giải quyết bài toán nghiệp vụ. Điều này cũng giúp website doanh nghiệp dễ dàng thay đổi hoặc nâng cấp các thành phần AI mà không làm phá vỡ cấu trúc tổng thể của mã nguồn.

Mỗi chuỗi được hình thành từ nhiều liên kết kế tiếp nhau, tạo nên một dây chuyền xử lý dữ liệu tự động. Mỗi liên kết đảm nhận một tác vụ chuyên biệt, chẳng hạn như:

- Liên kết thứ nhất: Tiếp nhận yêu cầu từ người dùng và định dạng vào mẫu lời nhắc.

- Liên kết thứ hai: Gửi truy vấn đã định dạng đến mô hình ngôn ngữ lớn (LLM).

- Liên kết thứ ba: Truy xuất dữ liệu bổ sung từ đám mây hoặc cơ sở dữ liệu vector nếu cần thiết.

- Liên kết cuối cùng: Trình phân tích kết quả sẽ định dạng lại dữ liệu trả về trước khi hiển thị cho người dùng.

Dữ liệu được truyền tải thông suốt qua các liên kết này bằng cách sử dụng các hàm thực thi như invoke hoặc chain.run. Kết quả từ một mắt xích này sẽ ngay lập tức trở thành đầu vào cho mắt xích tiếp theo, đảm bảo tính nhất quán và tốc độ xử lý tối ưu. Quy trình này giúp hệ thống hoạt động mạch lạc, giảm thiểu sai sót và cho phép người quản trị dễ dàng theo dõi dòng chảy của thông tin trong ứng dụng.

Các ứng dụng phổ biến của LangChain trong doanh nghiệp

1. Chatbot thông minh

Khác với các chatbot truyền thống chỉ hoạt động dựa trên các kịch bản có sẵn, chatbot xây dựng trên LangChain có khả năng tư duy và ghi nhớ ngữ cảnh vượt trội. Nhờ module Memory, trợ lý ảo có thể hiểu được dòng chảy của cuộc trò chuyện, từ đó đưa ra phản hồi tự nhiên và chính xác theo nhu cầu của người dùng. Doanh nghiệp có thể tích hợp các chatbot này vào các kênh liên lạc phổ biến như Zalo, Telegram hoặc trực tiếp lên website để hỗ trợ khách hàng 24/7 với phong cách chuyên nghiệp.

2. Hệ thống trả lời câu hỏi và tóm tắt văn bản

LangChain cho phép xây dựng các hệ thống có khả năng truy xuất thông tin từ kho tài liệu nội bộ như quy trình nhân sự, tài liệu kỹ thuật hoặc cơ sở dữ liệu y khoa để trả lời các câu hỏi chuyên sâu của nhân viên hoặc khách hàng. Bên cạnh đó, khả năng tóm tắt văn bản giúp người dùng nhanh chóng nắm bắt các ý chính từ những bản báo cáo dài hàng trăm trang, giúp tiết kiệm thời gian và nâng cao hiệu quả làm việc.

3. Virtual Agents

LangChain cho phép AI phản hồi bằng văn bản và còn có thể thực hiện các hành động thực tế thông qua AI Agent. Những tác tử ảo này có thể thay thế con người thực hiện quy trình nghiệp vụ tự động như tự động kiểm tra lịch hẹn, gọi API để cập nhật dữ liệu vào CRM hoặc giải quyết các bài toán logic phức tạp dựa trên dữ liệu thời gian thực. Điều này giúp doanh nghiệp tối ưu việc sử dụng nguồn nhân lực khỏi các tác vụ lặp đi lặp lại để tập trung vào các công việc sáng tạo hơn.

4. Phân tích và trích xuất dữ liệu

Một trong những thách thức lớn nhất của doanh nghiệp là xử lý dữ liệu phi cấu trúc từ email, hợp đồng hoặc các file PDF. LangChain cung cấp các công cụ mạnh mẽ để trích xuất thông tin có cấu trúc từ văn bản thuần túy và định dạng lại chúng thành JSON hoặc CSV để đưa vào hệ thống quản lý. Ngoài ra, framework này còn hỗ trợ tạo ra dữ liệu tổng hợp chất lượng cao phục vụ cho việc kiểm thử phần mềm hoặc đào tạo các mô hình AI nhỏ hơn mà không làm rò rỉ thông tin quan trọng.

Để bắt đầu xây dựng các ứng dụng trí tuệ nhân tạo chuyên nghiệp, việc thiết lập một môi trường lập trình chuẩn hóa là bước đi quan trọng đầu tiên. LangChain được thiết kế để dễ dàng tích hợp vào các dự án sẵn có, giúp lập trình viên nhanh chóng hiện thực hóa các ý tưởng từ bản thử nghiệm đến thực tế.

Vietnix – Nhà cung cấp dịch vụ VPS và cloud tốc độ cao, tối ưu cho mọi doanh nghiệp

Với cam kết mang lại nền tảng hạ tầng vững chắc cho sự phát triển trong kỷ nguyên số, Vietnix khẳng định vị thế là nhà cung cấp dịch vụ VPS và Enterprise Cloud tốc độ cao hàng đầu thị trường, được thiết kế tối ưu hóa chuyên biệt cho mọi quy mô doanh nghiệp. Hệ thống vận hành trên nền tảng phần cứng hiện đại với 100% ổ cứng SSD/NVMe kết hợp cùng các dòng vi xử lý thế hệ mới, đảm bảo khả năng xử lý dữ liệu tức thì và duy trì hiệu suất ổn định ngay cả trong những khung giờ cao điểm. Liên hệ ngay!

Thông tin liên hệ:

- Website: https://vietnix.vn/

- Hotline: 1800 1093

- Email: sales@vietnix.com.vn

- Địa chỉ: 265 Hồng Lạc, Phường Bảy Hiền, Thành Phố Hồ Chí Minh

Câu hỏi thường gặp

Nên sử dụng LangChain Python hay LangChain js?

Việc lựa chọn giữa LangChain Python và LangChain js phụ thuộc vào hệ sinh thái ứng dụng của bạn:

– LangChain Python: Phổ biến nhất và sở hữu cộng đồng hỗ trợ đông đảo, có thể tích hợp sâu với các thư viện khoa học dữ liệu, AI hiện có.

– LangChain js: Đây là lựa chọn phù hợp cho các lập trình viên muốn xây dựng ứng dụng AI chạy trực tiếp trên môi trường trình duyệt, Node.js hoặc các nền tảng serverless, giúp tối ưu hóa hiệu suất cho các ứng dụng web thời gian thực.

LangChain LLM hỗ trợ những mô hình ngôn ngữ nào?

LangChain LLM cung cấp giao diện chuẩn hóa để kết nối với hầu hết các mô hình ngôn ngữ lớn hàng đầu hiện nay như OpenAI (GPT-4), Anthropic (Claude), Google (Gemini). Ngoài ra, framework này cũng hỗ trợ các mô hình mã nguồn mở chạy cục bộ như Llama, Mistral thông qua các tích hợp với Ollama hoặc Hugging Face, mang lại sự linh hoạt tối đa cho nhà phát triển.

Vai trò của Langchain-chroma trong việc lưu trữ dữ liệu là gì?

Langchain-chroma là một tích hợp giữa LangChain và ChromaDB, đóng vai trò lưu trữ các bản nhúng của dữ liệu văn bản. Khi người dùng đặt câu hỏi, LangChain sẽ sử dụng Chroma để tìm kiếm các đoạn thông tin có ngữ nghĩa gần nhất, giúp AI có thêm ngữ cảnh chính xác để phản hồi mà không cần phải đào tạo lại toàn bộ mô hình.

Langchain tool hoạt động như thế nào trong các AI Agent?

Langchain tool là các hàm hoặc chức năng cho phép các Agent tương tác với bên ngoài. Thay vì chỉ xử lý văn bản, một Agent có thể tự quyết định sử dụng các công cụ như truy vấn tìm kiếm Google, thực hiện phép tính toán học hoặc gọi API đến hệ thống quản trị của doanh nghiệp.

LangChain GitHub là gì?

LangChain GitHub thường chỉ kho mã nguồn chính của LangChain trên GitHub tại org langchain-ai/langchain, nơi chứa code framework, ví dụ, issue và tài liệu cập nhật nhất.

LangChain RAG là gì?

LangChain RAG là việc dùng LangChain để xây dựng hệ thống Retrieval-Augmented Generation – Truy xuất tài liệu liên quan rồi dùng LLM sinh câu trả lời dựa trên tài liệu đó.

Tóm lại, LangChain là một framework quan trọng giúp LLM từ mô hình sinh văn bản đơn thuần trở thành nền tảng trung tâm cho các ứng dụng AI. Cụ thể, LangChain kết nối mô hình với dữ liệu thực tế, duy trì ngữ cảnh hội thoại, hỗ trợ xây dựng chuỗi xử lý và agent dùng công cụ, từ đó giúp lập trình viên phát triển và vận hành hệ thống AI tạo sinh dễ dàng, linh hoạt và hiệu quả hơn trong môi trường doanh nghiệp.

THEO DÕI VÀ CẬP NHẬT CHỦ ĐỀ BẠN QUAN TÂM

Đăng ký ngay để nhận những thông tin mới nhất từ blog của chúng tôi. Đừng bỏ lỡ cơ hội truy cập kiến thức và tin tức hàng ngày