Apache Spark là gì? Lợi ích khi sử dụng Apache Spark

Đã kiểm duyệt nội dung

Đánh giá

Apache Spark là một nền tảng xử lý dữ liệu lớn mã nguồn mở, nổi bật với khả năng xử lý song song cực nhanh trên bộ nhớ. Bài viết sẽ giúp bạn hiểu rõ Apache Spark là gì, các thành phần chính như Spark Core, Spark SQL, Spark Streaming, MLlib và GraphX. Ngoài ra, mình sẽ phân tích kiến trúc của Spark, những đặc điểm nổi bật giúp nó được ưa chuộng trong giới công nghệ. Cuối cùng, bạn sẽ thấy được lý do vì sao nhiều doanh nghiệp lớn đã chọn Spark để tối ưu xử lý dữ liệu quy mô lớn.

Điểm chính cần nắm

- Apache Spark là gì?: Giới thiệu khái quát về Apache Spark và vai trò của nó trong xử lý dữ liệu lớn.

- Các thành phần trong Apache Spark: Trình bày các module chính cấu thành hệ sinh thái Apache Spark.

- Đặc điểm nổi bật của Apache Spark là gì?: Tóm tắt những ưu điểm giúp Spark trở thành nền tảng xử lý dữ liệu mạnh mẽ.

- Kiến trúc của Apache Spark là gì?: Mô tả cấu trúc hoạt động và luồng xử lý trong hệ thống Spark.

- Top doanh nghiệp đã sử dụng Apache Spark: Liệt kê các công ty lớn ứng dụng Spark vào xử lý dữ liệu thực tế.

- Vietnix – Hạ tầng lý tưởng để triển khai Apache Spark: Giới thiệu giải pháp VPS hiệu năng cao tại Vietnix phù hợp triển khai Spark.

- FAQ: Tổng hợp câu hỏi thường gặp để người đọc hiểu sâu hơn về Apache Spark.

Apache Spark là gì?

Apache Spark là một framework mã nguồn mở dùng để xử lý dữ liệu lớn (Big Data) theo mô hình phân tán (Client server), được phát triển lần đầu bởi AMPLab vào năm 2009 và sau đó chuyển giao cho Apache Software Foundation vào năm 2013. Spark nổi bật nhờ khả năng xử lý song song trong bộ nhớ (in-memory computing), giúp tăng tốc độ tính toán vượt trội so với Hadoop MapReduce.

Spark hỗ trợ cả xử lý theo lô (batch) và thời gian thực (real-time), cho phép phân tích dữ liệu ngay khi vừa được thu thập từ nhiều nguồn khác nhau. Framework này không có hệ thống tệp riêng mà có thể làm việc linh hoạt với nhiều hệ thống như HDFS, Amazon S3, Cassandra…, hỗ trợ đa dạng định dạng dữ liệu và dễ dàng tích hợp vào các hệ sinh thái hiện có. Spark cũng đi kèm với các thư viện mạnh mẽ dành cho SQL, machine learning, xử lý luồng dữ liệu và phân tích đồ thị.

Các thành phần trong Apache Spark

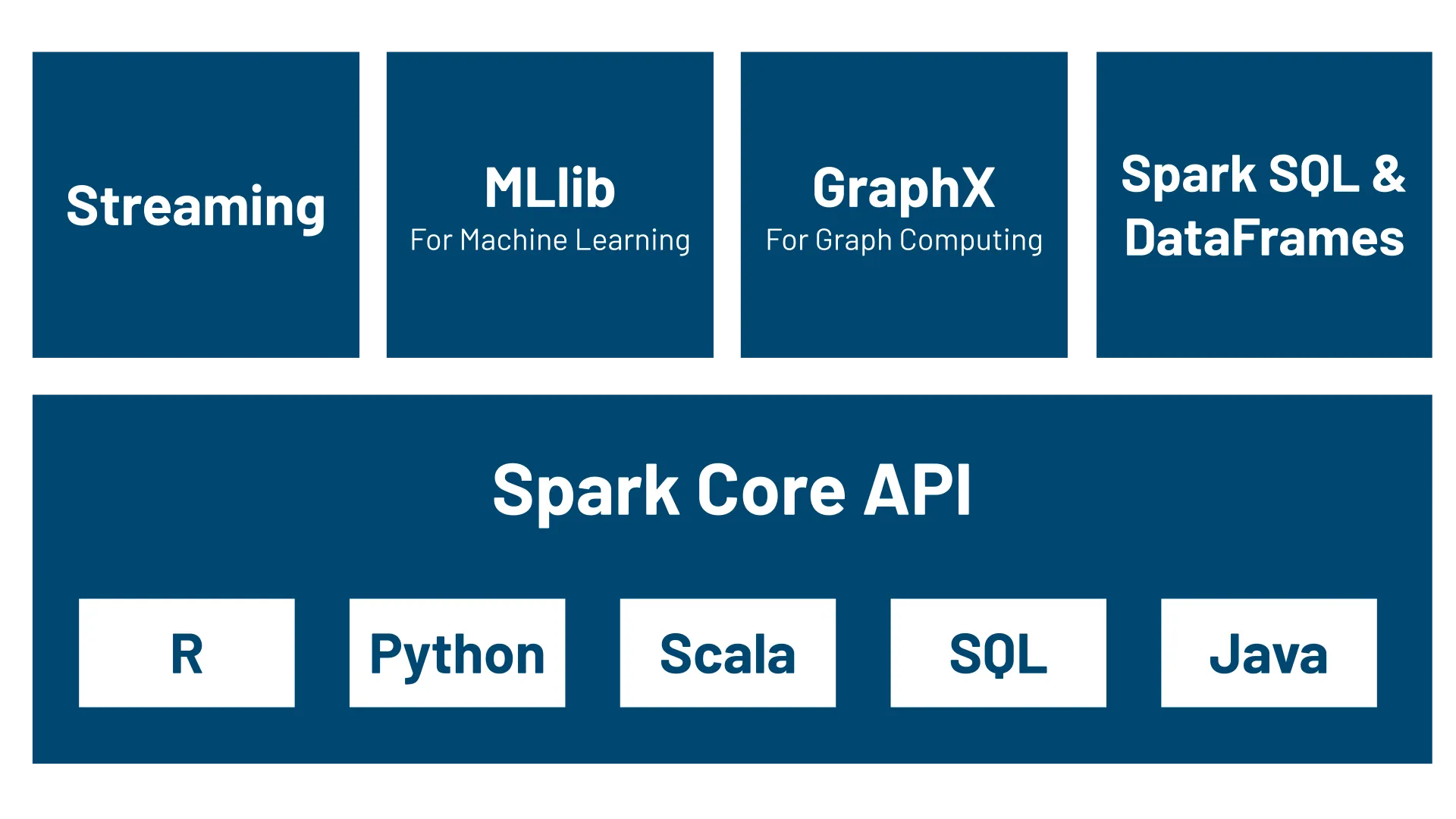

Công nghệ Apache Spark bao gồm 5 thành phần chính, đó là:

1. Spark Core

Đây là nền tảng cốt lõi của Apache Spark và các thành phần khác đều phụ thuộc vào Spark Core. Spark Core đảm nhiệm vai trò tính toán và xử lý dữ liệu bên trong bộ nhớ (in-memory computing) đồng thời thực hiện đối chiếu với các dữ liệu được liên kết với các hệ thống lưu trữ bên ngoài.

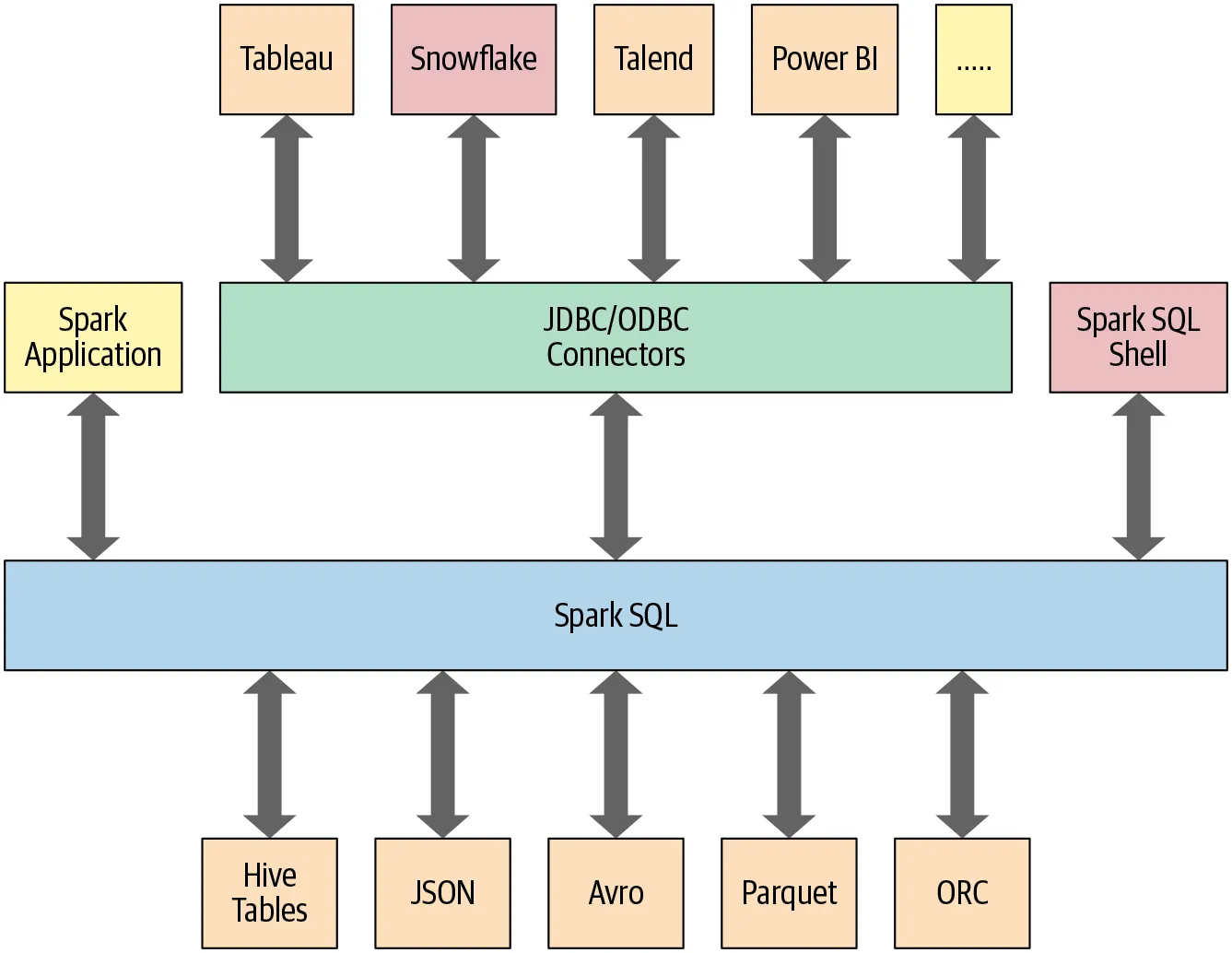

2. Spark SQL

Spark SQL cung cấp một kiểu data abstraction mới, gọi là SchemaRDD, để nhằm hỗ trợ cho cả dữ liệu có cấu trúc (structured data) và nửa cấu trúc (semi-structured data). Spark SQL cung cấp các API DSL (Domain-specific language) để thực hiện các thao tác trên DataFrames bằng Scala, Java hoặc Python và nó cũng hỗ trợ cả ngôn ngữ SQL với giao diện command-line và ODBC/JDBC server.

3. Spark Streaming

Spark Streaming được dùng để xử lý dữ liệu stream bằng cách chia nó thành các mini-batch và thực hiện các phép biến đổi RDD trên các mini-batch này. Qua đó giúp cho các đoạn code được viết riêng cho việc xử lý batch có thể được tận dụng lại vào trong quá trình xử lý stream. Đồng thời giúp cho việc phát triển lambda architecture dễ dàng hơn. Tuy nhiên, điều này có thể gây ra độ trễ trong xử lý dữ liệu (độ trễ chính bằng mini-batch duration), khiến nhiều chuyên gia tin rằng Spark Streaming không phải là một công cụ xử lý stream hiệu quả như Storm hoặc Flink.

4. Spark MLlib (Machine Learning Library)

Spark MLlib là một thư viện học máy phân tán trên Spark, sử dụng kiến trúc phân tán bộ nhớ. Spark MLlib đã được chuyên trang công nghệ benchmark đánh giá là có tốc độ nhanh hơn gấp 9 lần so với phiên bản chạy trên Hadoop.

5. GraphX

GraphX là một nền tảng xử lý đồ thị trên Spark, cung cấp các API để thực hiện các tính toán trên đồ thị bằng cách sử dụng Pregel API.

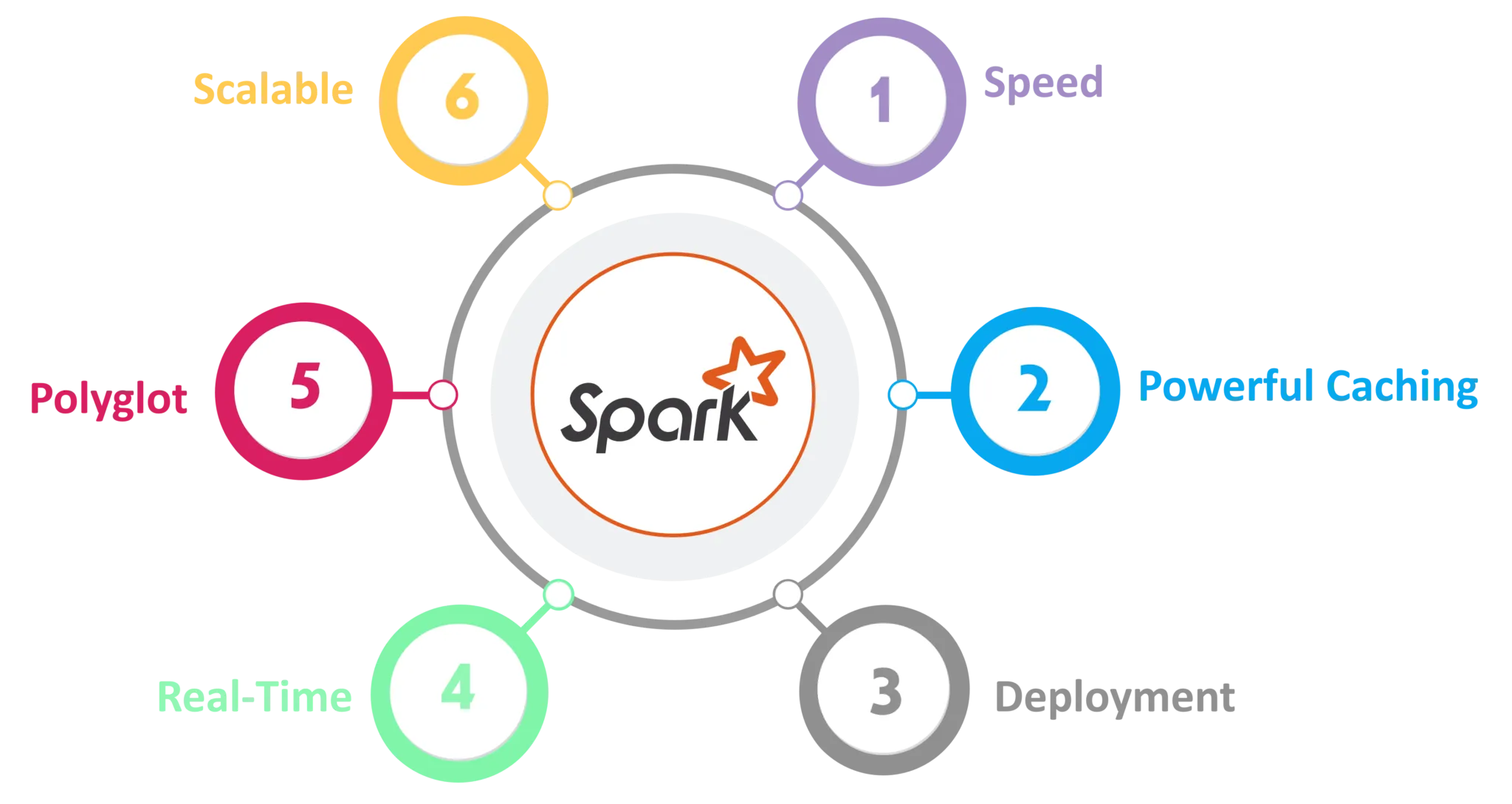

Đặc điểm nổi bật của Apache Spark là gì?

Apache Spark là một framework xử lý dữ liệu mạnh mẽ và hiệu quả. Nó có khả năng xử lý dữ liệu theo lô và thời gian thực, có thể tích hợp được với tất cả các nguồn dữ liệu và định dạng tệp được hỗ trợ bởi cụm Hadoop. Đồng thời mã nguồn này cũng hỗ trợ nhiều ngôn ngữ lập trình khác nhau như Java, Scala, Python và ngôn ngữ R.

Với khả năng xử lý dữ liệu thời gian thực, Apache Spark có thể xử lý hàng triệu sự kiện mỗi giây từ các luồng sự kiện thời gian thực như Data Twitter hoặc lượt chia sẻ, bài đăng trên Facebook. Nó cũng có thể được sử dụng để phát hiện gian lận trong các giao dịch ngân hàng. Tất cả các khoản thanh toán đều được thực hiện trong thời gian thực và Apache Spark có thể giúp ngăn chặn các giao dịch gian lận trong khi quá trình thanh toán đang diễn ra.

Không những thế, Apache Spark còn có thể được sử dụng để xử lý dữ liệu nhanh và tương tác, xử lý đồ thị, công việc lặp đi lặp lại, xử lý thời gian thực, joining Dataset và Machine Learning. Tuy nhiên, Apache Spark không thể thay thế hoàn toàn cho Hadoop mà chỉ là một framework ứng dụng được phát triển trên nền tảng Hadoop HDFS. Mặc dù nó ra đời sau nhưng lại được nhiều người biết đến hơn Apache Hadoop vì khả năng xử lý hàng loạt và thời gian thực mạnh mẽ của nó.

Khi triển khai Apache Spark để xử lý dữ liệu lớn, một hệ thống chỉ thực sự hiệu quả khi có nền tảng hạ tầng đủ mạnh để đáp ứng yêu cầu tính toán song song và truy xuất nhanh. VPS AMD tại Vietnix sử dụng CPU AMD EPYC nhiều nhân, kết hợp ổ SSD NVMe và mạng tốc độ cao, giúp các tác vụ Spark chạy ổn định, phân phối tốt và dễ dàng mở rộng. Bên cạnh đó, tường lửa bảo mật riêng và đội ngũ hỗ trợ kỹ thuật 24/7 đảm bảo hệ thống luôn sẵn sàng và an toàn trong mọi tình huống.

VPS AMD HIỆU NĂNG CAO – VIETNIX

Nền tảng lý tưởng cho xử lý dữ liệu lớn, tối ưu hiệu suất Apache Spark từ phát triển đến sản xuất.

Kiến trúc của Apache Spark

Apache Spark được cấu thành từ hai phần chính là trình thực thi (executors) và trình điều khiển (driver). Trong đó, trình điều khiển có nhiệm vụ giúp chuyển đổi mã của người dùng thành các tác vụ (tasks), sau đó phân phối chúng trên các nút xử lý (worker nodes). Trình thực thi sẽ thực hiện các tác vụ này và chạy trên các nút xử lý mà trình điều khiển giao cho nó.

Ngoài ra, Spark cũng có thể hoạt động ở chế độ cụm độc lập mà chỉ yêu cầu JVM và khung Apache Spark trên mỗi máy trong cụm. Tuy nhiên, việc sử dụng công cụ quản lý cụm như một trình trung gian giữa 2 thành phần sẽ giúp tài nguyên được phân bổ theo đúng yêu cầu và tận dụng hiệu quả hơn.

Đặc biệt, Apache Spark sử dụng đồ thị vòng có hướng (DAG) để xây dựng các lệnh xử lý dữ liệu. DAG là lớp lập lịch của Spark, quyết định tác vụ nào được thực thi trên nút xử lý nào và theo trình tự nào.

Top doanh nghiệp đã sử dụng Apache Spark

Hiện nay, có rất nhiều doanh nghiệp và thương hiệu lớn đã và đang sử dụng Apache Spark cho các sản phẩm của mình như Yahoo, IBM, ebay, Cisco,… Để triển khai Apache Spark một cách hiệu quả, bạn cần một môi trường ổn định và mạnh mẽ. Lúc này giải pháp tốt nhất là lựa chọn sử dụng VPS.

Vietnix – Hạ tầng lý tưởng để triển khai Apache Spark

Để vận hành Apache Spark hiệu quả, bạn cần một hạ tầng đủ mạnh, tốc độ cao và ổn định – đó cũng chính là thế mạnh của dịch vụ VPS và hosting tại Vietnix. Với hệ thống máy chủ hiện đại, CPU nhiều nhân, ổ cứng SSD NVMe và kết nối mạng tốc độ cao, Vietnix giúp bạn xử lý dữ liệu lớn mượt mà, giảm độ trễ và tăng hiệu suất xử lý phân tán. Đội ngũ kỹ thuật chuyên môn cao luôn sẵn sàng hỗ trợ 24/7, đảm bảo hệ thống Spark hoạt động ổn định và bảo mật.

Thông tin liên hệ:

- Website: https://vietnix.vn/

- Hotline: 1800 1093

- Email: sales@vietnix.com.vn

- Địa chỉ: 265 Hồng Lạc, Phường Bảy Hiền, Thành Phố Hồ Chí Minh

Câu hỏi thường gặp

Apache Spark khác gì so với Apache Hadoop?

Spark xử lý dữ liệu nhanh hơn Hadoop nhờ sử dụng RAM thay vì chỉ dùng đĩa. Ngoài ra, Spark hỗ trợ xử lý real-time, còn Hadoop chủ yếu theo lô (batch).

PySpark là gì?

PySpark là một giao diện Python cho Apache Spark, cho phép lập trình xử lý dữ liệu phân tán bằng ngôn ngữ Python.

Apache Spark có thể xử lý dữ liệu real-time không?

Có. Apache Spark hỗ trợ xử lý dữ liệu thời gian thực thông qua module Spark Streaming hoặc Structured Streaming.

Spark SQL hoạt động như thế nào?

Spark SQL cho phép viết truy vấn SQL để thao tác trên dữ liệu phân tán, đồng thời hỗ trợ tích hợp với các DataFrame và nguồn dữ liệu như Hive, Parquet.

Làm sao để tối ưu hiệu năng Spark Job thực tế?

Dùng cache đúng lúc, chọn đúng partition size, tránh dùng collect() không cần thiết, và theo dõi metrics bằng Spark UI.

Spark Structured Streaming có thể thay thế Kafka không?

Làm sao để đăng nhập vào Spark UI khi chạy Spark Local?

Sau khi chạy job, Spark UI thường có tại http://localhost:4040. Có thể xem thông tin DAG, storage, execution detail tại đây.

Lời kết

Apache Spark mang lại hiệu suất cao, khả năng mở rộng linh hoạt và hỗ trợ đa dạng công cụ, giúp doanh nghiệp khai thác dữ liệu lớn hiệu quả hơn. Nếu bạn đang tìm kiếm một giải pháp xử lý dữ liệu mạnh mẽ, Spark là lựa chọn đáng cân nhắc. Nếu bạn có bất kỳ thắc mắc nào về kiến trúc, thành phần hay cách triển khai Apache Spark, đừng ngần ngại để lại bình luận. Mình sẽ giải đáp và hỗ trợ bạn tận tình.

THEO DÕI VÀ CẬP NHẬT CHỦ ĐỀ BẠN QUAN TÂM

Đăng ký ngay để nhận những thông tin mới nhất từ blog của chúng tôi. Đừng bỏ lỡ cơ hội truy cập kiến thức và tin tức hàng ngày