Tensor Core là gì? Tổng hợp thông tin từ A-Z về Tensor Core

Đã kiểm duyệt nội dung

Đánh giá

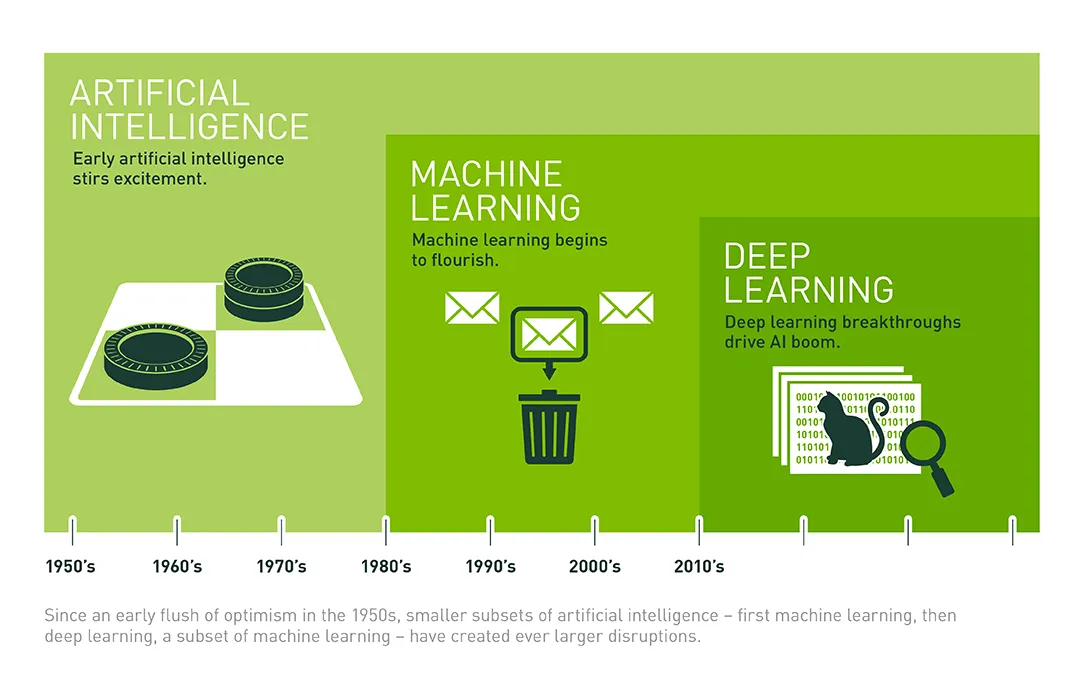

Trong lĩnh vực trí tuệ nhân tạo (AI) ngày càng phát triển, nhu cầu về sức mạnh tính toán khổng lồ là điều tất yếu. Tensor Core, một công nghệ đột phá từ NVIDIA, đã xuất hiện như một giải pháp phần cứng chuyên dụng, được thiết kế để đáp ứng và tăng tốc các tác vụ AI và Deep Learning. Trong bài viết này, mình sẽ giúp bạn hiểu rõ về Tensor Core, cùng với đó là các chức năng, lợi ích, các ứng dụng phổ biến và quan trọng của Tensor Core.

Những điểm chính

- Tensor Core là gì: Tensor Core là các nhân xử lý chuyên dụng trên GPU NVIDIA, được thiết kế để tăng tốc cực nhanh các phép toán ma trận (MMA), cốt lõi của AI và Deep Learning.

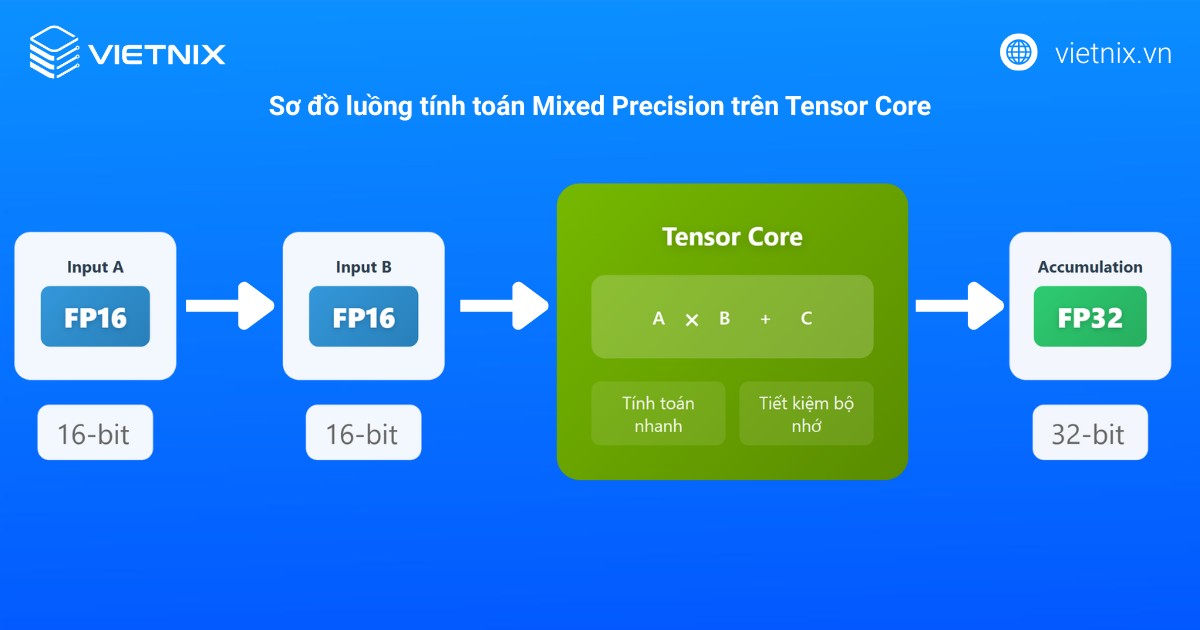

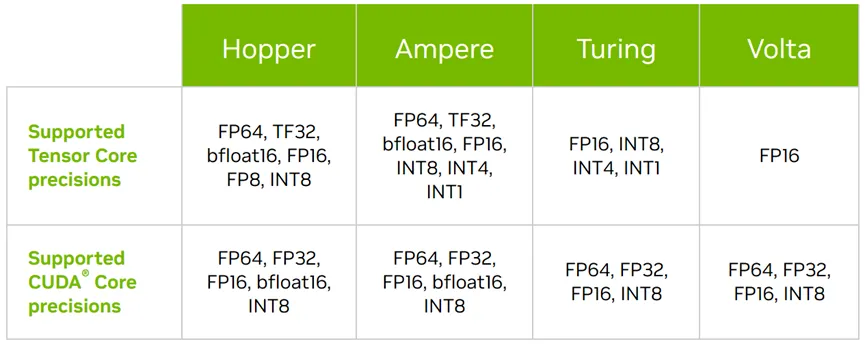

- Cơ chế hoạt động của Tensor Core: Tận dụng tính toán chính xác hỗn hợp (mixed-precision) để tăng tốc độ, giảm sử dụng bộ nhớ mà vẫn đảm bảo độ chính xác cho mô hình AI. Hỗ trợ các định dạng như FP16, TF32, INT8, FP8.

- Lợi ích chính của Tensor Core: Tăng tốc đáng kể quá trình huấn luyện (training) và suy luận (inference) mô hình AI, nâng cao hiệu quả năng lượng (FLOPs/watt), cho phép xử lý các mô hình AI lớn và phức tạp hơn.

- Ứng dụng phổ biến của Tensor Core: Huấn luyện và triển khai mô hình Deep Learning (thị giác máy tính, NLP, nhận dạng giọng nói), HPC, phân tích dữ liệu lớn, đồ họa máy tính (NVIDIA DLSS).

- So sánh với CPU và CUDA Core: Tensor Core không thay thế mà bổ sung cho CPU (điều phối) và CUDA Core (xử lý song song đa năng), mang lại hiệu suất vượt trội cho các tác vụ ma trận chuyên biệt trong AI.

- Các thế hệ Tensor Core: NVIDIA liên tục cải tiến qua các thế hệ GPU (Volta, Turing, Ampere, Hopper, Ada Lovelace), mang lại hiệu năng và tính năng ngày càng mạnh mẽ hơn.

- Giải pháp VPS GPU Vietnix: Cung cấp cách tiếp cận linh hoạt, tiết kiệm chi phí để khai thác sức mạnh của GPU NVIDIA có Tensor Core, với hạ tầng tối ưu, hỗ trợ chuyên nghiệp và độ ổn định cao cho các dự án AI.

Tổng quan về Tensor Core

Tensor là gì?

Tensor là một cấu trúc dữ liệu đa chiều, có thể được xem là sự tổng quát hóa của vô hướng (scalar – tensor 0 chiều), vector (tensor 1 chiều) và ma trận (matrix – tensor 2 chiều) lên các không gian có nhiều chiều hơn. Nhờ tính linh hoạt này, tensor có khả năng biểu diễn và xử lý hiệu quả nhiều loại dữ liệu khác nhau, từ các giá trị số đơn giản đến hình ảnh, video và văn bản. Trong AI và Machine Learning, tensor là công cụ cốt lõi để lưu trữ, xử lý dữ liệu đầu vào, biểu diễn các tham số của mô hình, cũng như các hàm toán học phức tạp như hàm phân phối xác suất.

Tensor Core là gì?

Tensor Core (Lõi Tensor) là một loại phần cứng xử lý chuyên dụng được NVIDIA tích hợp trực tiếp vào kiến trúc của một số dòng card đồ họa (GPU) của họ, bắt đầu từ kiến trúc Volta và tiếp tục phát triển qua các thế hệ như Turing, Ampere và Hopper.

Chức năng chính của Tensor Core là tăng tốc đáng kể các phép toán ma trận và tensor, đặc biệt là phép nhân ma trận và tích lũy (Matrix Multiplication and Accumulation – MMA), một trong những phép toán nền tảng, chiếm phần lớn khối lượng tính toán trong các thuật toán mạng nơ-ron nhân tạo, từ các lớp tích chập, lớp hồi quy cho đến cơ chế chú ý trong các mô hình Transformers tiên tiến.

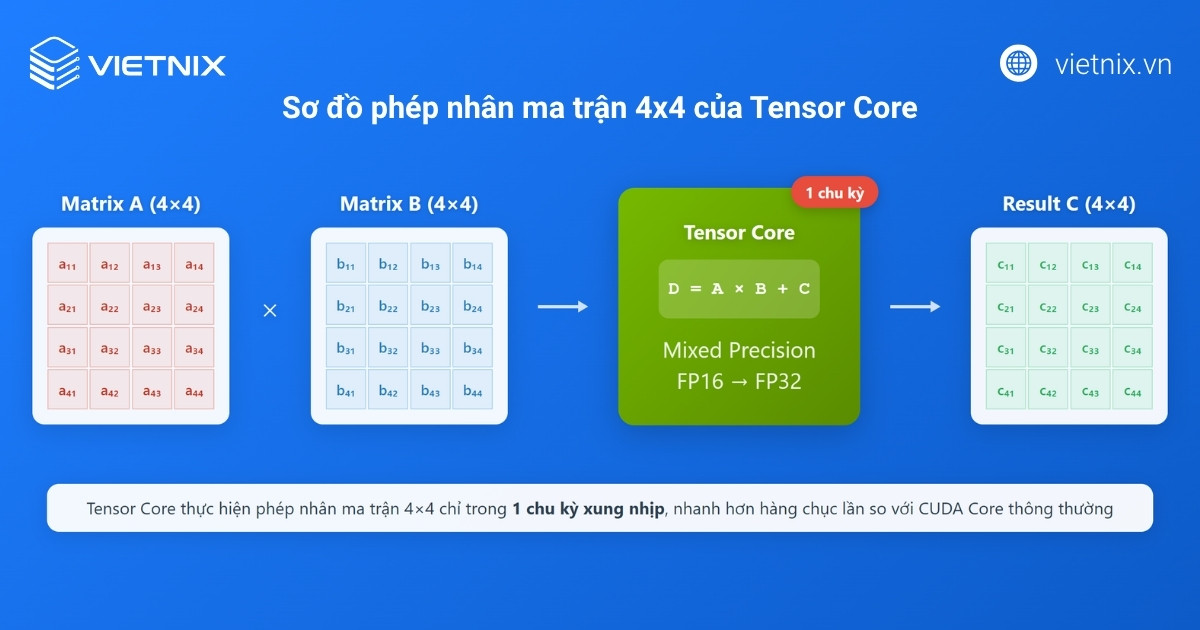

Một đặc điểm nổi bật của Tensor Core là khả năng thực hiện phép tính Fused Multiply-Add (FMA) trên các ma trận nhỏ (ví dụ, 4×4) với độ chính xác hỗn hợp (mixed-precision) chỉ trong một chu kỳ xung nhịp. Có nghĩa là Tensor Core có thể nhận đầu vào ở các định dạng số có độ chính xác thấp hơn (như FP16, BF16, INT8, FP8) để tính toán nhanh hơn, trong khi vẫn có thể tích lũy kết quả ở độ chính xác cao hơn (như FP32) để duy trì độ chính xác tổng thể của mô hình.

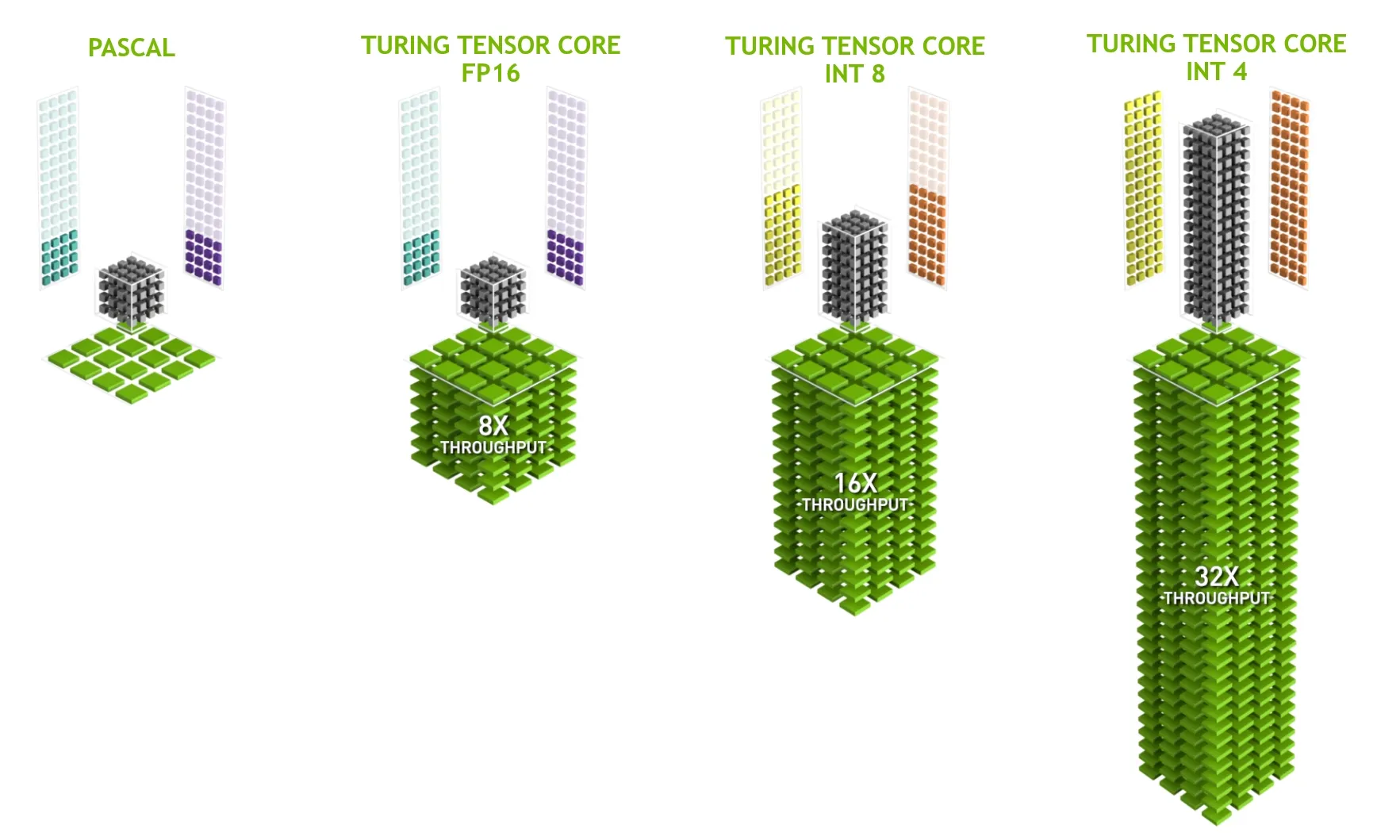

Cơ chế tính toán hỗn hợp độ chính xác kết hợp với phép toán Fused Multiply-Add tốc độ cao trên các phép nhân ma trận nhỏ mang lại thông lượng (throughput) cao hơn nhiều lần so với việc sử dụng các lõi CUDA thông thường cho cùng một tác vụ, giúp rút ngắn đáng kể thời gian huấn luyện (training) và suy luận (inference) của các mô hình AI, đồng thời tối ưu hóa hiệu suất cho các ứng dụng tính toán hiệu năng cao (HPC).

Phép toán ma trận (Tensor Operations) trong AI

Các phép toán ma trận giữ vai trò trung tâm trong hầu hết thuật toán trí tuệ nhân tạo và học sâu hiện đại. Dưới đây là những minh họa dễ thấy về tầm quan trọng và tần suất sử dụng của chúng:

- Mạng nơ-ron tích chập (CNN): Trong xử lý ảnh, các bộ lọc liên tục được quét qua dữ liệu ảnh gốc. Toàn bộ thao tác này thực chất là quá trình nhân và cộng ma trận lặp lại ở nhiều lớp của mạng. Đây là nền tảng giúp CNN phát hiện cạnh, hoa văn, hình dạng ở các mức độ chi tiết khác nhau trên hình ảnh.

- Mô hình ngôn ngữ lớn (LLM, ví dụ Transformers): Cơ chế tự chú ý (Self-attention) tạo ra các ma trận truy vấn, khóa và giá trị (Q, K, V), sau đó kết hợp bằng các phép nhân ma trận phức tạp để tính toán sự liên kết giữa tất cả các từ trong câu hoặc đoạn văn. Việc này đòi hỏi khối lượng rất lớn các thao tác nhân–cộng ma trận đồng thời ở mỗi lớp của mô hình.

Vì các phép toán này xuất hiện với tần suất cực lớn và là cốt lõi của các mô hình AI, việc tăng tốc chúng sẽ cải thiện đáng kể hiệu năng tổng thể của toàn bộ quá trình huấn luyện và suy luận.

Cơ chế hoạt động của Tensor Core

Tensor Core là lõi xử lý chuyên biệt trong các GPU NVIDIA hiện đại, được thiết kế để tăng tốc mạnh mẽ các phép toán nhân–cộng ma trận, nền tảng của các thuật toán AI và Deep Learning hiện nay. Thay vì thực hiện các phép nhân, phép cộng tuần tự như lõi CUDA truyền thống, mỗi Tensor Core có thể đồng thời đảm trách hàng loạt phép toán nhân cộng trên các ma trận nhỏ (ví dụ 4×4) chỉ trong một chu kỳ xung nhịp, giúp tăng tốc xử lý vượt trội.

Một trong những đặc điểm nổi bật là khả năng xử lý hỗn hợp độ chính xác: Tensor Core chấp nhận đầu vào dưới dạng số thực 16 bit (FP16), bfloat16, INT8 hoặc thậm chí FP8. Nhờ đó, tốc độ thực hiện phép toán được tối ưu, dung lượng bộ nhớ tiết kiệm, trong khi kết quả các phép tích lũy vẫn được lưu trữ ở độ chính xác cao hơn (FP32), đảm bảo chất lượng mô hình không suy giảm – rất quan trọng với các bài toán AI cần cân bằng tối ưu giữa hiệu suất và độ chính xác kết quả.

Công nghệ Fused Multiply-Add cũng là điểm then chốt của Tensor Core, cho phép xử lý đồng thời cả phép nhân và phép cộng trên từng phần tử ma trận nhỏ chỉ trong một bước, mỗi chu kỳ có thể thực hiện song song hàng nghìn phép toán, tối ưu băng thông bộ nhớ và hiệu suất tiêu thụ điện năng. Tensor Core trực tiếp truy cập vào bộ nhớ đệm tốc độ cao, giảm đáng kể độ trễ, đồng thời linh hoạt thích ứng với nhiều chuẩn dữ liệu số ở các thế hệ mới.

Chính nhờ cơ chế này, Tensor Core không chỉ rút ngắn thời gian huấn luyện và suy luận của các mô hình AI mà còn vượt trội khi ứng dụng trong các lĩnh vực HPC, mô phỏng khoa học, cũng như xử lý đồ họa chuyên sâu.

Lợi ích chính và các ứng dụng phổ biến của Tensor Core

Tensor Core mang lại nhiều lợi ích vượt trội và có ứng dụng rộng rãi trong nhiều lĩnh vực.

Lợi ích chính

- Tăng tốc độ huấn luyện: Giảm đáng kể thời gian cần thiết để huấn luyện các mô hình AI/Deep Learning phức tạp, cho phép các nhà nghiên cứu và phát triển thử nghiệm nhiều ý tưởng hơn trong thời gian ngắn hơn. Ví dụ, một tác vụ huấn luyện có thể giảm từ vài tuần xuống chỉ còn vài ngày.

- Tăng tốc độ suy luận: Cải thiện đáng kể hiệu suất khi triển khai mô hình AI để đưa ra dự đoán trên dữ liệu mới. Điều này đặc biệt quan trọng đối với các ứng dụng đòi hỏi phản hồi thời gian thực.

- Hiệu quả năng lượng vượt trội: Cung cấp nhiều teraFLOPs (nghìn tỷ phép tính dấu phẩy động mỗi giây) trên mỗi watt điện tiêu thụ hơn so với việc chỉ dùng CUDA core cho các tác vụ ma trận, giúp tiết kiệm chi phí vận hành.

- Xử lý mô hình AI lớn hơn và phức tạp hơn: Khả năng tính toán mạnh mẽ kết hợp với tối ưu hóa bộ nhớ thông qua mixed precision cho phép các nhà phát triển làm việc với những mô hình có hàng tỷ tham số.

Ứng dụng phổ biến

- Huấn luyện và triển khai mô hình Deep Learning:

- Thị giác máy tính (Computer Vision): Nhận dạng đối tượng, phân loại hình ảnh, phân đoạn ảnh, ứng dụng trong xe tự lái.

- Xử lý ngôn ngữ tự nhiên (NLP): Dịch máy, chatbots, phân tích cảm xúc, tóm tắt văn bản, và các mô hình ngôn ngữ lớn (LLM).

- Nhận dạng giọng nói (Speech Recognition): Xây dựng trợ lý ảo thông minh, chuyển đổi giọng nói thành văn bản và ngược lại.

- Điện toán hiệu năng cao (HPC): Một số lĩnh vực trong HPC, như mô phỏng khoa học và phân tích dữ liệu lớn, cũng sử dụng các phép tính ma trận tương tự, do đó Tensor Core có thể tăng tốc đáng kể các tác vụ này.

- Xử lý dữ liệu lớn (Big Data Analytics): Tăng tốc các thuật toán phân tích dữ liệu dựa trên ma trận, giúp khai phá thông tin chi tiết từ lượng dữ liệu khổng lồ nhanh chóng hơn.

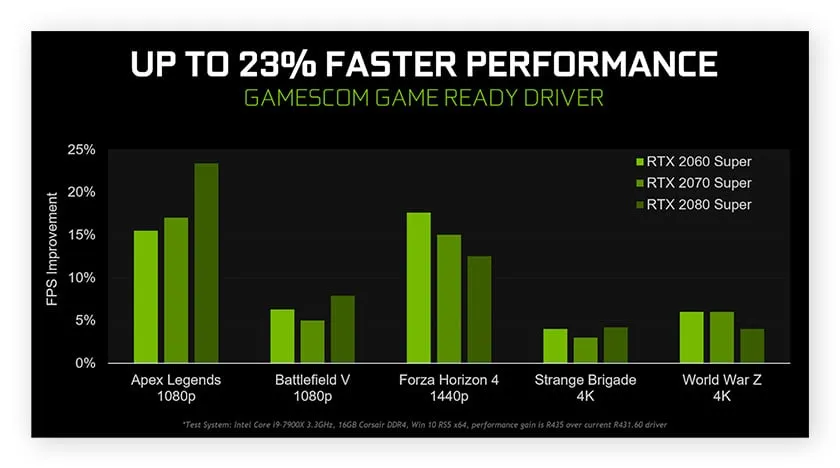

- Đồ họa máy tính (Computer Graphics): Một ví dụ điển hình là công nghệ NVIDIA DLSS. DLSS sử dụng AI và Tensor Core để nâng cấp hình ảnh từ độ phân giải thấp lên độ phân giải cao hơn trong trò chơi, giúp cải thiện tốc độ khung hình (FPS) mà vẫn duy trì chất lượng hình ảnh tốt.

So sánh Tensor Core với CUDA Core và CPU

Để hiểu rõ hơn vai trò của Tensor Core, chúng ta hãy so sánh với hai loại lõi xử lý phổ biến khác: CPU và CUDA Core.

- CPU:

- Mô tả: Được coi là bộ não của máy tính, CPU được thiết kế để xử lý đa dạng các tác vụ một cách tuần tự hoặc song song ở mức độ hạn chế.

- Điểm mạnh: Rất linh hoạt trong việc xử lý các tác vụ đa năng, logic điều khiển phức tạp, và quản lý hệ thống.

- Ứng dụng tiêu biểu: Thích hợp xử lý các tác vụ văn phòng, lập trình, quản trị hệ thống, điều khiển thiết bị ngoại vi, điều phối các tiến trình máy tính, chạy phần mềm ứng dụng tổng quát và các tác vụ đòi hỏi luồng xử lý phức tạp từng bước như giả lập, phân tích dữ liệu nhỏ, cơ sở dữ liệu truyền thống.

- Hạn chế cho AI: Số lượng lõi ít (vài chục lõi), không được tối ưu cho các phép toán song song quy mô lớn như nhân ma trận, vốn là cốt lõi của các thuật toán AI.

- CUDA Core:

- Mô tả: Là các lõi xử lý song song cơ bản có mặt trong hầu hết các GPU của NVIDIA.

- Điểm mạnh: Có khả năng thực hiện hàng ngàn phép toán song song cùng lúc, lý tưởng cho các tác vụ đồ họa, mô phỏng vật lý, tính toán khoa học nói chung, và các tác vụ AI không chuyên biệt về ma trận hoặc khi Tensor Core không khả dụng.

- Ứng dụng tiêu biểu: Rất phù hợp xử lý hình ảnh, render đồ họa 3D, mô phỏng khoa học, tăng tốc một số thuật toán AI ở độ chính xác cao (FP32, FP64) hoặc những mô hình AI cũ/chưa được tối ưu dùng Tensor Core, chạy Deep Learning khi thao tác không thiên về phép nhân ma trận đặc trưng (ví dụ: augmentation dữ liệu, thao tác hậu xử lý).

- Hạn chế so với Tensor Core cho AI: Mặc dù CUDA Core có thể thực hiện phép nhân ma trận, thông lượng của chúng thấp hơn đáng kể so với Tensor Core khi xử lý các phép toán ma trận mà Tensor Core hỗ trợ (ví dụ:

FP16,TF32).

- Tensor Core:

- Mô tả: Là đơn vị phần cứng chuyên biệt được tích hợp trong các GPU NVIDIA hiện đại.

- Điểm mạnh: Chuyên biệt hóa cao độ cho các phép toán nhân ma trận và tích lũy (MMA) với độ chính xác hỗn hợp. Cung cấp hiệu suất tính toán (FLOPs) cao hơn nhiều lần so với CUDA Core trên các tác vụ này, đồng thời tiết kiệm năng lượng hơn.

- Ứng dụng tiêu biểu: Là chìa khóa tăng tốc các tác vụ trí tuệ nhân tạo, nhất là huấn luyện và inference các mô hình Deep Learning phức tạp như mạng tích chập, mô hình ngôn ngữ lớn, các cơ chế attention/truy vấn – vốn đòi hỏi vô số phép nhân ma trận đồng thời. Ngoài AI, Tensor Core cũng được dùng trong các tác vụ HPC như mô phỏng khoa học, phân tích dữ liệu quy mô cực lớn trong y sinh, tài chính, mô hình khí hậu.

- Hạn chế: Ít linh hoạt hơn CUDA Core, chủ yếu tăng tốc các loại phép toán cụ thể được thiết kế.

Bảng so sánh chi tiết:

| Tính năng/Tiêu chí | CPU (Central Processing Unit) | CUDA Core (trong NVIDIA GPU) | Tensor Core (trong NVIDIA GPU) |

|---|---|---|---|

| Mục đích chính | Đa năng, tuần tự, điều khiển | Song song đa năng | Song song chuyên biệt (AI/DL) |

| Số lượng lõi | Ít (vài chục) | Nhiều (hàng trăm đến hàng ngàn) | Ít hơn CUDA Core (vài chục đến vài trăm) |

| Tối ưu cho | Tác vụ phức tạp, I/O, logic | Đồ họa, tính toán song song | Phép toán ma trận (MMA) |

| Độ chính xác hỗ trợ | Đa dạng (FP32, FP64…) | Đa dạng (FP32, FP64…) | Hỗn hợp (FP16, TF32, INT8, FP8…) |

| Hiệu suất/FLOPs (AI) | Thấp | Trung bình | Rất cao (cho tác vụ chuyên biệt) |

| Linh hoạt | Rất cao | Cao | Trung bình (cho tác vụ cụ thể) |

| Ứng dụng chính trong AI | Điều phối, tiền/hậu xử lý | Các tác vụ AI không dùng MMA | Huấn luyện/Suy luận DL (MMA) |

Kết luận so sánh: CPU, CUDA Core và Tensor Core không loại trừ lẫn nhau mà bổ sung cho nhau trong một hệ thống tính toán hiện đại. CPU đảm nhận vai trò điều phối chung, CUDA Core xử lý các tác vụ song song đa dạng, và Tensor Core siêu tăng tốc các phép toán ma trận cốt lõi của AI. Một GPU NVIDIA hiện đại thường tích hợp cả hàng ngàn CUDA Core và hàng trăm Tensor Core.

Các thế hệ Tensor Core của NVIDIA

NVIDIA liên tục cải tiến công nghệ Tensor Core qua mỗi thế hệ kiến trúc GPU, mang lại hiệu năng và khả năng ngày càng vượt trội.

- Volta (GPU GV100 – ví dụ: Tesla V100): Đây là thế hệ đầu tiên giới thiệu Tensor Core, tập trung vào việc tăng tốc các phép nhân ma trận

FP16và tích lũy kết quả sangFP32. Volta đã tạo ra một bước nhảy vọt về hiệu năng cho việc huấn luyện AI.

- Turing (GPU TU10x – ví dụ: GeForce RTX 20 series, Quadro RTX, Tesla T4): Tensor Core thế hệ thứ hai được cải tiến, bổ sung hỗ trợ cho các phép toán

INT8vàINT4giúp tăng tốc các tác vụ suy luận (inference) với độ trễ thấp và hiệu quả năng lượng cao.

- Ampere (GPU GA10x – ví dụ: GeForce RTX 30 series, NVIDIA A100, RTX A-series): Tensor Core thế hệ thứ ba mang đến nhiều cải tiến lớn:

- Giới thiệu định dạng

TF32, cho phép đạt tốc độ gần bằngFP16nhưng vẫn giữ được dải động củaFP32, giúp dễ dàng tăng tốc mà không cần thay đổi mã nguồn nhiều. - Tăng cường hiệu năng cho

FP16,BF16 (BFloat16). - Hỗ trợ Sparsity (tính thưa), giúp tăng tốc xử lý các ma trận thưa (có nhiều giá trị 0), một đặc điểm phổ biến trong nhiều mô hình AI, có thể nhân đôi hiệu suất.

- Giới thiệu định dạng

- Hopper (GPU GH100 – ví dụ: NVIDIA H100): Tensor Core thế hệ thứ tư tiếp tục đẩy xa giới hạn hiệu năng:

- Giới thiệu hỗ trợ định dạng

FP8 (8-bit floating point), cung cấp thông lượng gấp đôi so vớiFP16, giúp tăng tốc đáng kể cho cả huấn luyện và suy luận các mô hình ngôn ngữ lớn (LLM) và các mô hình AI siêu lớn khác. - Tích hợp Transformer Engine, một công nghệ tự động tối ưu và chọn lựa giữa các định dạng

FP8vàFP16để đạt hiệu suất cao nhất mà vẫn giữ độ chính xác cho các mô hình Transformer.

- Giới thiệu hỗ trợ định dạng

- (Tùy chọn) Ada Lovelace (GPU AD10x – ví dụ: GeForce RTX 40 series): Mang Tensor Core thế hệ thứ tư với những tối ưu riêng cho gaming và sáng tạo nội dung, ví dụ như công nghệ DLSS 3 Frame Generation.

Khai thác sức mạnh Tensor Core cho dự án AI/DL với VPS GPU Vietnix

Sở hữu và vận hành các GPU NVIDIA hiện đại có Tensor Core (như A100, H100…) đòi hỏi chi phí đầu tư, vận hành, bảo trì và kỹ thuật rất lớn, là rào cản với nhiều cá nhân, startup và doanh nghiệp nhỏ. Dịch vụ VPS GPU của Vietnix mang đến giải pháp tiếp cận GPU Tensor Core một cách chủ động, tiết kiệm mà không cần lo lắng về phần cứng, điện năng hay làm mát.

Dưới đây là những lý do tại sao dịch vụ máy chủ ảo tại Vietnix là lựa chọn hàng đầu cho các dự án AI của bạn:

- Cung cấp sẵn hạ tầng GPU mạnh mẽ: Vietnix trang bị các dòng card đồ họa NVIDIA mới và mạnh mẽ nhất, được trang bị Tensor Core. Bạn có thể truy cập và sử dụng ngay lập tức mà không cần lo lắng về việc mua sắm hay lắp đặt phức tạp.

- Hạ tầng tối ưu cho hiệu suất: Máy chủ của Vietnix được cấu hình với CPU hiệu năng cao, dung lượng RAM lớn, ổ cứng NVMe tốc độ cực nhanh và kết nối mạng băng thông rộng. Toàn bộ môi trường được tối ưu hóa cho các tác vụ tính toán song song, đảm bảo GPU có thể hoạt động ở công suất tối đa.

- Được hỗ trợ bởi chuyên gia Vietnix: Đội ngũ kỹ thuật của Vietnix có kinh nghiệm dày dặn trong việc vận hành và hỗ trợ các hệ thống GPU phức tạp. Vietnix sẵn sàng hỗ trợ bạn cài đặt môi trường (driver NVIDIA, CUDA Toolkit, cuDNN), tối ưu hóa hiệu năng, và giải quyết nhanh chóng các vấn đề kỹ thuật phát sinh.

- Ổn định và bảo mật: Hạ tầng của Vietnix được đặt tại các trung tâm dữ liệu (data center) đạt chuẩn quốc tế Tier III, đảm bảo uptime cao, nguồn điện ổn định và hệ thống làm mát hiệu quả.

Thông tin liên hệ:

- Website: https://vietnix.vn/

- Hotline: 1800 1093

- Email: sales@vietnix.com.vn

- Địa chỉ: 265 Hồng Lạc, Phường Bảy Hiền, Thành Phố Hồ Chí Minh

Câu hỏi thường gặp

Tensor Core có trên dòng card nào của NVIDIA?

Tensor Core thường có mặt trên các dòng card đồ họa NVIDIA như:

– Card đồ họa NVIDIA dành cho trung tâm dữ liệu (Data Center GPUs) như Tesla (V100, T4), NVIDIA A-series (A100, A40, A30), NVIDIA H-series (H100).

– Các dòng card cho máy trạm chuyên nghiệp như Quadro RTX, NVIDIA RTX A-series (ví dụ: RTX A6000) và cả các dòng card gaming cao cấp GeForce RTX (từ RTX 20-series trở đi).

Lưu ý quan trọng: Số lượng và thế hệ Tensor Core sẽ khác nhau giữa các model. Luôn kiểm tra thông số kỹ thuật cụ thể của từng model card đồ họa.

Tôi có cần học lập trình GPU (ví dụ: CUDA) mới để dùng Tensor Core không?

Không nhất thiết cho hầu hết người dùng. Các framework AI/Deep Learning phổ biến như TensorFlow, PyTorch, MXNet đã tích hợp sẵn khả năng tận dụng Tensor Core thông qua các thư viện cấp thấp được NVIDIA tối ưu như cuDNN và TensorRT .

Khi bạn viết code bằng các framework này và sử dụng các phép toán được hỗ trợ, nếu phần cứng có Tensor Core và các thư viện được cài đặt đúng cách, chúng sẽ tự động được sử dụng để tăng tốc.

Tensor Core có giúp tăng tốc mọi thứ trên GPU không?

Câu trả lời là không. Tensor Core được thiết kế chuyên biệt để tăng tốc các phép toán ma trận nhân và tích lũy (MMA) cụ thể, thường là với độ chính xác hỗn hợp (FP16, TF32, INT8, FP8…). Các tác vụ đồ họa 3D truyền thống hay các tác vụ tính toán song song không liên quan trực tiếp đến các phép toán ma trận này vẫn chủ yếu dựa vào sức mạnh của các CUDA Core.

Làm thế nào để biết mô hình AI của tôi đang sử dụng Tensor Core?

Có một số cách để kiểm tra mà bạn có thể cân nhắc là:

– Kiểm tra logs từ framework AI, sử dụng công cụ profiling của NVIDIA như NVIDIA Nsight Systems hoặc Nsight Compute.

– Kiểm tra tài liệu hướng dẫn tối ưu hiệu suất của TensorFlow/PyTorch để đảm bảo bạn đã kích hoạt các tùy chọn cần thiết (ví dụ: Automatic Mixed Precision – AMP).

Tensor Core thực sự là một công nghệ phần cứng mang tính cách mạng của NVIDIA, đóng vai trò then chốt trong việc tăng tốc các ứng dụng AI và Deep Learning. Việc tiếp cận và khai thác sức mạnh này không còn là rào cản lớn nhờ các giải pháp linh hoạt và hiệu quả như VPS GPU của Vietnix. Hãy liên hệ với Vietnix để được tư vấn ngay nhé!

THEO DÕI VÀ CẬP NHẬT CHỦ ĐỀ BẠN QUAN TÂM

Đăng ký ngay để nhận những thông tin mới nhất từ blog của chúng tôi. Đừng bỏ lỡ cơ hội truy cập kiến thức và tin tức hàng ngày