Khắc phục lỗi “Volume is already exclusively attached to one node” hiệu quả

Đã kiểm duyệt nội dung

Đánh giá

Lỗi “Volume is already exclusively attached to one node” là một thông báo lỗi phổ biến trong Kubernetes, xuất hiện khi một volume đang được gắn độc quyền vào một node, nhưng Kubernetes lại cố gắng gắn volume đó sang một node khác. Trong bài viết này, mình sẽ giúp bạn hiểu rõ hơn các nguyên nhân gây ra lỗi, cách chẩn đoán, giải pháp khắc phục tạm thời và các chiến lược kiến trúc để phòng tránh xung đột gắn volume.

Những điểm chính

- Khái niệm: Hiểu rõ “Volume is already exclusively attached to one node” là lỗi xung đột tài nguyên lưu trữ, giúp bạn nhanh chóng xác định nguyên nhân đến từ việc volume không thể di chuyển giữa các node.

- Các tình huống thường gặp: Nhận biết các kịch bản thực tế thường gây ra lỗi, giúp bạn chủ động phòng tránh và chẩn đoán sự cố hiệu quả hơn.

- Nguyên nhân gây lỗi: Nắm vững các nguyên nhân phổ biến từ accessMode không phù hợp đến các sự cố detach volume, giúp bạn có một danh sách kiểm tra hiệu quả để khoanh vùng và chẩn đoán sự cố.

- Dấu hiệu và cách kiểm tra: Nhận biết các dấu hiệu như Pod bị kẹt và nắm vững các lệnh kubectl cần thiết, giúp bạn thu thập thông tin và xác nhận chính xác lỗi đang xảy ra.

- Cách xử lý tạm thời: Tìm hiểu các giải pháp khắc phục nhanh như scale replica về 0, giúp bạn nhanh chóng gỡ kẹt volume và khôi phục hoạt động của ứng dụng.

- Giải pháp kiến trúc và cấu hình để tránh xung đột: Nắm vững các phương pháp thiết kế đúng đắn từ việc chọn accessMode phù hợp đến cấu hình StatefulSet, giúp bạn giải quyết triệt để nguyên nhân gốc rễ và xây dựng một hệ thống bền vững.

- Các biện pháp phòng ngừa lỗi: Nắm được các phương pháp hay nhất trong việc cấu hình và giám sát, giúp bạn chủ động phòng tránh sự cố và đảm bảo hệ thống lưu trữ hoạt động ổn định.

- Giới thiệu Vietnix: Biết đến Vietnix là nhà cung cấp các giải pháp hạ tầng đa dạng, giúp bạn có một nền tảng vững chắc để xây dựng các hệ thống Kubernetes chuyên biệt, hạn chế các sự cố phức tạp.

- Câu hỏi thường gặp: Giải đáp các thắc mắc liên quan đến lỗi “Volume is already exclusively attached to one node”.

Lỗi “Volume is already exclusively attached to one node” là gì?

“Volume is already exclusively attached to one node and can’t be attached to another” là thông báo lỗi xuất hiện khi một volume (thường là PV/PVC dạng block storage) đang được gắn độc quyền vào một node, nhưng Kubernetes lại cố gắng gắn volume đó sang một node khác.

Lỗi này thường liên quan tới các PVC sử dụng access mode ReadWriteOnce (RWO) hoặc ReadWriteOncePod (RWOP), vốn chỉ cho phép một node (hoặc một Pod duy nhất) gắn volume tại một thời điểm, nên bất kỳ yêu cầu gắn thêm từ node khác đều bị từ chối.

Trong nhiều trường hợp, lỗi xảy ra khi Pod bị lên lịch lại sang node mới do sự cố, scale, drain node hoặc thay đổi cấu trúc cụm, nhưng storage backend (EBS, vSphere, Longhorn,…) chưa kịp tách volume khỏi node cũ, khiến controller vẫn coi volume đang “exclusively attached” ở đó.

Hệ quả là Pod mới gắn cùng PVC sẽ kẹt ở trạng thái Pending hoặc ContainerCreating kèm sự kiện FailedAttachVolume, cho đến khi volume được giải phóng đúng cách khỏi node ban đầu.

Các tình huống thường gặp gây ra lỗi “Volume is already exclusively attached to one node”

Lỗi này thường phát sinh trong các bối cảnh vận hành cụ thể của một cụm Kubernetes.

- Sự cố và phục hồi Node (Node Failure and Recovery): Khi một node gặp sự cố đột ngột, Kubernetes có thể không hoàn tất được quy trình gỡ (detach) volume khỏi node đó. Do đó, khi node phục hồi hoặc khi các pod được lập lịch để gắn vào các node khác, volume này về mặt logic vẫn được ghi nhận là đang gắn vào node đã bị lỗi, điều này ngăn cản mọi yêu cầu gắn mới.

- Lập lịch lại Pod với tần suất cao (Aggressive Pod Rescheduling): Khi các pod được lập lịch hoặc bị trục xuất (evicted) do các chính sách lập lịch quyết liệt, có những trường hợp volume không được gỡ bỏ đúng cách. Đồng thời, Kubernetes cố gắng lập lịch lại pod đó trên một node khác, dẫn đến một tình trạng race condition (tranh chấp) giữa node cũ và node mới.

- Độ trễ từ nhà cung cấp lưu trữ (Storage Provider Latency): Độ trễ API ở phía nhà cung cấp lưu trữ cũng có thể ảnh hưởng đến quá trình gỡ volume. Xung đột này phát sinh trong các tình huống khi API mất quá nhiều thời gian để xử lý một yêu cầu gỡ, trong khi Kubernetes đã khởi tạo một yêu cầu gắn mới.

- Hoạt động co giãn cụm (Cluster Scaling Operations): Rất nhiều hoạt động diễn ra đồng thời trong quá trình tự động co giãn cụm. Nếu sự phối hợp về mặt thời gian của bất kỳ hoạt động nào trong số này không chính xác, lỗi xung đột volume có thể phát sinh.

Để giải quyết triệt để các nguyên nhân gốc rễ này, việc lựa chọn một nền tảng hạ tầng ổn định và hiệu năng cao là yếu tố quyết định. Dịch vụ cho thuê cloud server của Vietnix đáp ứng yêu cầu này nhờ kiến trúc có tính sẵn sàng cao (HA) giúp xử lý sự cố node, và hệ thống lưu trữ 100% NVMe Enterprise giảm thiểu độ trễ. Nền tảng Enterprise Cloud này đảm bảo các thao tác volume trong Kubernetes diễn ra mượt mà, hạn chế tối đa rủi ro xung đột.

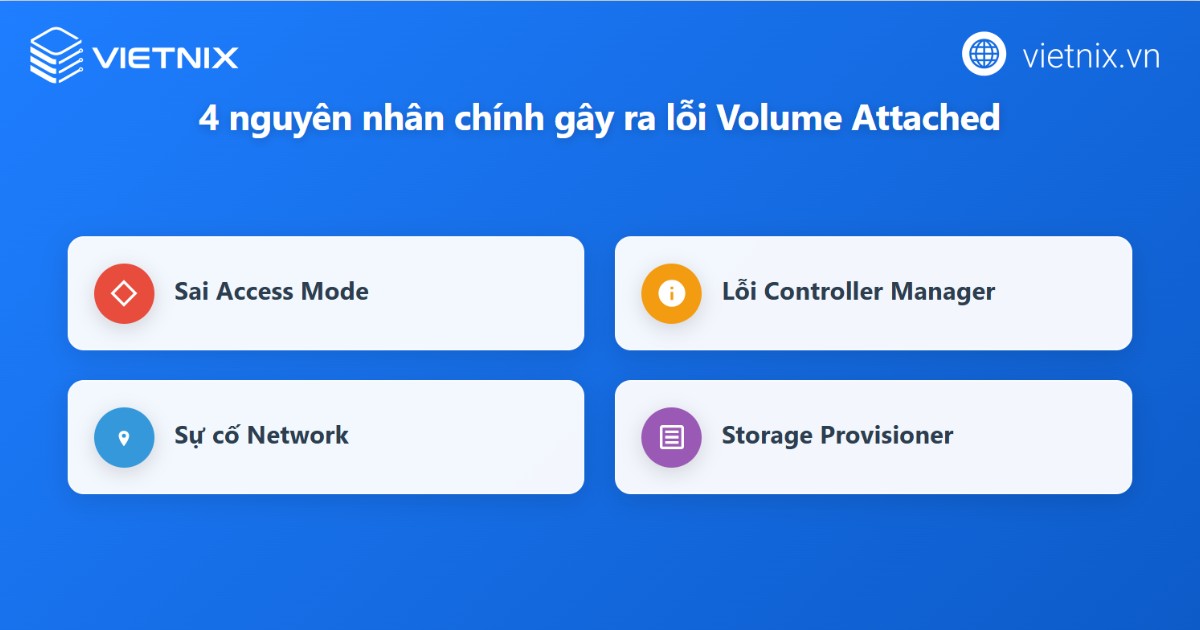

Nguyên nhân gây lỗi “Volume is already exclusively attached to one node”

Access mode không phù hợp với cách sử dụng

Nguyên nhân đầu tiên là PVC/PV được tạo với accessMode chỉ cho phép gắn trên một node như ReadWriteOnce (RWO) hoặc ReadOnlyOnce (ROO), nhưng lại được dùng cho nhiều Pod chạy trên các node khác nhau hoặc nhiều replica cùng chia sẻ một PVC. Ngoài ra, workload có nhu cầu nhiều Pod cùng đọc/ghi chung dữ liệu nhưng StorageClass không cung cấp volume hỗ trợ chia sẻ (như ReadWriteMany hoặc backend dạng NFS, CephFS), dẫn đến xung đột khi Kubernetes cố gắng gắn volume sang node khác.

Volume vẫn bị giữ trạng thái “attached” trên node cũ

Nguyên nhân thứ hai là Pod cũ sử dụng volume bị lỗi, treo ở trạng thái Terminating hoặc xóa chưa sạch, khiến quá trình detach volume khỏi node không hoàn tất và controller vẫn ghi nhận volume đang gắn với node cũ. Trong một số trường hợp, đối tượng VolumeAttachment hoặc thông tin ở tầng storage/cloud provider vẫn đánh dấu volume là attached, nên yêu cầu attach từ node mới bị từ chối với thông báo “volume is already exclusively attached to one node”.

Cấu hình StorageClass và PVC không khớp nhu cầu truy cập

Nguyên nhân tiếp theo đến từ việc StorageClass được cấu hình mặc định tạo volume dạng RWO trong khi thiết kế workload lại yêu cầu nhiều Pod/Replica cùng truy cập chung PVC. Việc dùng một PVC duy nhất cho nhiều replica stateful, thay vì mỗi replica một PVC riêng, làm tăng khả năng Pod được đặt trên các node khác nhau nhưng vẫn chia sẻ một volume chỉ cho phép gắn độc quyền.

Vấn đề từ controller, scheduler hoặc storage backend

Nguyên nhân cuối cùng là độ trễ hoặc lỗi tạm thời ở tầng storage backend (EBS, vSphere, Longhorn, CSI driver…), khiến thao tác detach/attach không được cập nhật kịp thời vào trạng thái volume. Một số trường hợp được ghi nhận do race condition hoặc lỗi xử lý ở controller/scheduler, khi Pod được di chuyển giữa các node nhưng quy trình detach khỏi node cũ và attach sang node mới không được thực hiện theo đúng thứ tự, dẫn đến lỗi “volume is already exclusively attached to one node”.

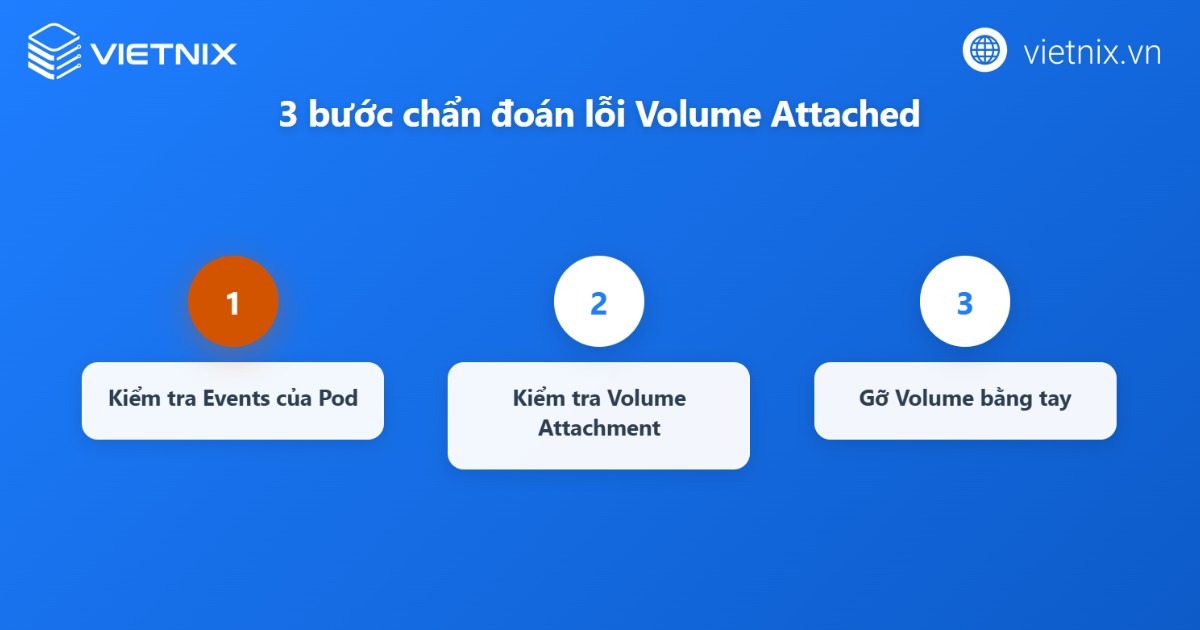

Dấu hiệu nhận biết và cách kiểm tra trạng thái volume

Pod ở trạng thái Pending/ContainerCreating kèm cảnh báo FailedAttachVolume

Khi xảy ra lỗi “Volume is already exclusively attached to one node”, Pod thường không thể khởi động hoàn chỉnh và bị giữ ở trạng thái Pending hoặc ContainerCreating trong thời gian dài. Nếu xem chi tiết mô tả Pod, phần events sẽ hiển thị các cảnh báo kiểu FailedAttachVolume hoặc Multi-Attach error, trong đó thông báo rõ volume đang được gắn độc quyền vào một node khác và không thể attach sang node mới.

Kiểm tra event trên Pod, PVC, PV để xác định node đang giữ volume

Bước tiếp theo là dùng lệnh mô tả Pod, PVC và PV để kiểm tra chuỗi sự kiện liên quan đến việc gắn volume. Trong event của Pod và PVC, có thể thấy tên node mà controller đang cố gắng attach volume, cùng với thông điệp chỉ ra volume đang attached ở node nào hoặc thao tác attach/detach có bị lỗi hay không. Với PV, phần status và thông tin claimRef cũng hỗ trợ xác định PVC nào đang tham chiếu tới volume đó và tình trạng bound hiện tại.

Dùng VolumeAttachment và log controller để xác định mối liên kết volume–node hiện tại

Để kiểm tra chính xác mối liên kết giữa volume và node, có thể liệt kê và mô tả các đối tượng VolumeAttachment do CSI hoặc cloud controller tạo ra. Trong mỗi VolumeAttachment, trường chỉ định volume ID và nodeName giúp xác định volume đang được coi là gắn với node nào ở tầng điều khiển.

Ngoài ra, log của controller chịu trách nhiệm attach/detach (như csi-attacher, cloud-controller-manager) cũng ghi lại thông tin chi tiết về các yêu cầu attach/detach, lỗi từ phía storage backend và lý do volume vẫn bị đánh dấu “exclusively attached” trên node cũ.

Cách xử lý tạm thời khi gặp lỗi “Volume is already exclusively attached to one node”

Giảm replica và khởi động lại workload gắn với PVC

Cách xử lý tạm thời thường được khuyến nghị là giảm số replica của Deployment/StatefulSet về 0 để tất cả Pod đang sử dụng PVC liên quan dừng hẳn, tạo điều kiện cho hệ thống detach volume khỏi node cũ.

Sau khi xác nhận volume đã được tách (thông qua event, VolumeAttachment hoặc giao diện cloud), có thể scale lại replica lên giá trị mong muốn để Pod được gắn volume trở lại trên node mới.

Trong trường hợp chỉ có một Pod độc lập dùng PVC, có thể xóa Pod đó và để controller (Deployment, StatefulSet) tự tạo lại Pod mới hoặc tạo lại Pod thủ công nếu không dùng controller. Cách này giúp khởi động lại chu trình attach/detach của volume mà không thay đổi PVC/PV.

Thao tác với VolumeAttachment hoặc detach thủ công theo hướng dẫn storage

Nếu volume vẫn bị giữ trạng thái attached dù Pod đã dừng, có thể cần kiểm tra và thao tác với đối tượng VolumeAttachment mà CSI driver hoặc cloud controller tạo ra. Trong một số tình huống được mô tả, quản trị viên xóa VolumeAttachment bị kẹt hoặc thực hiện detach thủ công qua giao diện cloud (ví dụ AWS EBS, vSphere) để giải phóng volume khỏi node cũ, sau đó để Kubernetes attach lại cho Pod mới.

Việc can thiệp trực tiếp vào VolumeAttachment hoặc thao tác detach trên backend cần tuân theo hướng dẫn cụ thể của nhà cung cấp storage, nhằm tránh gây mất đồng bộ trạng thái hoặc hỏng volume. Sau khi detach thành công, thường cần chờ một khoảng ngắn để controller cập nhật trạng thái trước khi Pod được khởi động lại.

Xóa và tạo lại PV/PVC trong trường hợp dữ liệu không quan trọng

Đối với các workload không yêu cầu giữ lại dữ liệu, ví dụ môi trường thử nghiệm, dữ liệu có thể tái tạo…, một số câu trả lời và hướng dẫn đề xuất xóa PVC/PV liên quan và tạo lại từ đầu. Cách này giải quyết triệt để liên kết giữa volume cũ và node, nhưng chỉ nên áp dụng khi đã chắc chắn dữ liệu có thể bỏ hoặc đã được sao lưu ở nơi khác.

Trong khi xóa, có thể cần force delete Pod, PVC hoặc sử dụng tham số thời gian chờ phù hợp nếu tài nguyên đang ở trạng thái Terminating kéo dài. Sau khi tạo PVC/PV mới, workload sẽ gắn với volume mới và không còn chịu ảnh hưởng từ trạng thái “exclusively attached” của volume cũ.

Giải pháp kiến trúc và cấu hình để tránh xung đột gắn volume

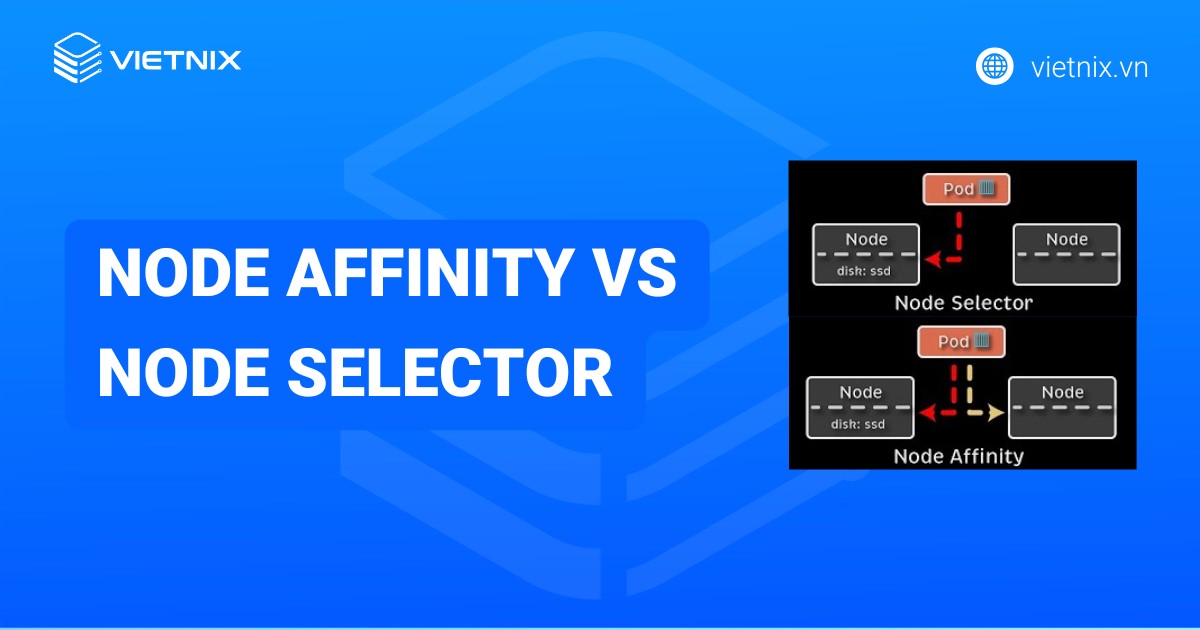

Thiết kế PVC và access mode phù hợp với mô hình truy cập

Về mặt kiến trúc, cách quan trọng nhất để tránh xung đột “volume is already exclusively attached to one node” là thiết kế PVC và access mode phù hợp với cách ứng dụng truy cập dữ liệu. Với workload stateful chạy nhiều replica trên các node khác nhau, nên thiết kế mỗi replica dùng một PVC/PV riêng (một Pod – một volume) khi access mode là ReadWriteOnce, thay vì cho nhiều Pod dùng chung một PVC duy nhất.

Nếu ứng dụng thực sự cần nhiều Pod ở nhiều node cùng đọc/ghi chung dữ liệu, bạn cần cân nhắc sử dụng loại storage hỗ trợ ReadWriteMany hoặc giải pháp lưu trữ chia sẻ như NFS, CephFS, Portworx, thay vì dùng block storage RWO truyền thống. Khi chọn StorageClass, nên kiểm tra kỹ các access mode mà driver hỗ trợ và ánh xạ rõ chúng với nhu cầu thực tế của từng nhóm ứng dụng như chia sẻ đọc/ghi, chỉ đọc, độc quyền theo Pod/node,…

Cấu hình Deployment/StatefulSet và chiến lược reschedule

Ở cấp cấu hình workload, cần tránh mẫu triển khai nhiều replica cùng tham chiếu chung một PVC/PV với access mode chỉ cho phép gắn độc quyền, đặc biệt trong Deployment không kiểm soát chặt số lượng Pod dùng cùng PVC. Đối với StatefulSet, có thể tận dụng cơ chế volumeClaimTemplates để mỗi replica có PVC tách biệt, từ đó giảm khả năng xung đột khi Pod được đặt lên các node khác nhau.

Ngoài ra, nên kết hợp với các cơ chế lập lịch và gián đoạn như PodDisruptionBudget, PodAffinity/Anti‑Affinity, nodeAffinity để hạn chế việc Pod bị di chuyển giữa node một cách dồn dập, nhất là với workload dùng block storage RWO. Việc kiểm soát reschedule và số lượng Pod đồng thời truy cập một PVC góp phần giảm tình huống storage backend chưa kịp detach volume khỏi node cũ đã phải attach sang node mới, vốn là nguyên nhân phổ biến của lỗi “exclusively attached”.

Các biện pháp phòng ngừa lỗi “Volume is already exclusively attached”

Quy định rõ cách dùng access mode theo loại ứng dụng

Cần phân nhóm workload theo cách truy cập dữ liệu (đọc/ghi độc quyền, chỉ đọc, đọc/ghi chia sẻ) và ánh xạ rõ với access mode tương ứng như ReadWriteOnce, ReadOnlyMany, ReadWriteMany ngay từ bước thiết kế PVC/StorageClass. Với ứng dụng stateful nhiều replica chạy trên các node khác nhau, nên dùng mô hình “một Pod – một PVC/PV” cho volume RWO hoặc chuyển sang loại storage hỗ trợ chia sẻ nếu thật sự cần nhiều Pod cùng truy cập.

Hạn chế reschedule gây kẹt volume bằng PDB và Affinity

Nên sử dụng PodDisruptionBudget (PDB) để giới hạn số Pod bị gián đoạn cùng thời điểm trong quá trình bảo trì, nâng cấp node hoặc autoscaling, tránh tình trạng nhiều Pod dùng cùng PVC bị chuyển node liên tiếp. Kết hợp PodAffinity/PodAnti‑Affinity và nodeAffinity giúp kiểm soát vị trí Pod, phân phối hợp lý workload có trạng thái trên các node, giảm nguy cơ dồn Pod về các node mới trong khi volume vẫn đang gắn ở node cũ.

Giám sát log, event và kiểm tra VolumeAttachment định kỳ

Cụm nên được cấu hình thu thập log và event từ kube-controller-manager, csi‑attacher/cloud‑controller và các Pod sử dụng PVC để phát hiện sớm cảnh báo FailedAttachVolume hoặc thông báo “volume is already exclusively attached to one node”. Định kỳ kiểm tra danh sách VolumeAttachment, đối chiếu với trạng thái PV/PVC và node để phát hiện kịp thời các volume vẫn bị giữ attached dù không còn Pod sử dụng, từ đó xử lý trước khi gây ảnh hưởng đến các lần triển khai sau.

Thiết lập tham số dừng Pod và quy tắc drain node hợp lý

Cần cấu hình terminationGracePeriodSeconds đủ lớn cho các Pod stateful để quá trình tắt Pod có đủ thời gian flush dữ liệu, hủy mount và detach volume đúng trình tự. Khi drain hoặc bảo trì node, nên áp dụng quy trình node drain chuẩn (hoặc playbook nhà cung cấp storage như Portworx khuyến nghị) để bảo đảm các volume được unmount và detach an toàn trước khi Pod được chuyển sang node khác.

Cân nhắc giải pháp lưu trữ phù hợp cho workload stateful

Với các ứng dụng stateful phức tạp, có thể xem xét sử dụng giải pháp lưu trữ phân tán chuyên biệt như Portworx hoặc các hệ thống tương đương để tận dụng khả năng quản lý volume, multi‑attach, failover và tự động xử lý trạng thái attach/detach tốt hơn so với backend block storage thô. Những nền tảng này thường cung cấp thêm công cụ quan sát, cảnh báo và cơ chế tự phục hồi cho volume, góp phần giảm xác suất gặp lỗi “volume is already exclusively attached to one node” trong môi trường sản xuất.

Vietnix – Giải pháp hạ tầng vững chắc cho dự án Kubernetes chuyên biệt

Để hạ tầng không còn là rào cản, bên cạnh giải pháp Enterprise Cloud chuyên dụng, Vietnix còn mang đến một hệ sinh thái hạ tầng toàn diện, giúp doanh nghiệp tránh xa các sự cố phức tạp. Sự ổn định đó được xây dựng trên các lựa chọn đa dạng từ VPS linh hoạt, máy chủ vật lý hiệu năng cao, cho đến dịch vụ thuê chỗ đặt máy chủ chuyên nghiệp tại Datacenter chuẩn Tier 3.

Với hơn 13 năm kinh nghiệm và là đối tác của hàng ngàn doanh nghiệp, Vietnix mang đến một môi trường vận hành tin cậy, giúp các ứng dụng quan trọng luôn hoạt động liên tục và an toàn. Nền tảng này được thiết kế để doanh nghiệp có thể tập trung vào phát triển thay vì lo lắng về các vấn đề vận hành.

Hãy khám phá các giải pháp hạ tầng được thiết kế cho sự tăng trưởng và tìm ra lựa chọn phù hợp nhất cho doanh nghiệp của bạn.

Thông tin liên hệ:

- Website: https://vietnix.vn/

- Hotline: 1800 1093

- Email: sales@vietnix.com.vn

- Địa chỉ: 265 Hồng Lạc, Phường Bảy Hiền, Thành Phố Hồ Chí Minh

Câu hỏi thường gặp

Kubernetes lưu trữ các volume ở đâu?

Kubernetes không lưu toàn bộ dữ liệu volume trong chính control plane mà chỉ quản lý và gắn/mount các volume được cung cấp bởi hạ tầng bên dưới như đĩa cục bộ, mạng lưu trữ, cloud disk, NFS,… Vị trí lưu trữ thực tế phụ thuộc vào loại volume: với emptyDir hoặc hostPath thì dữ liệu nằm trên filesystem của node (ổ đĩa vật lý, SSD hoặc tmpfs), còn với PersistentVolume thì dữ liệu nằm trên backend tương ứng như EBS, vSphere, Ceph, NFS theo cấu hình StorageClass.

Kích thước tối thiểu của PVC trong Kubernetes là bao nhiêu?

Bản thân Kubernetes không đặt một ngưỡng cứng cho kích thước tối thiểu của PVC mà chỉ yêu cầu giá trị dung lượng hợp lệ theo đơn vị hỗ trợ (Mi, Gi, Ti,…), còn giới hạn nhỏ nhất phụ thuộc vào plugin/StorageClass hoặc nền tảng lưu trữ cụ thể. Ví dụ, một số hệ thống như Azure Nexus định nghĩa tối thiểu 1 MiB cho một số StorageClass, còn các driver khác (Ceph, cloud disk…) có thể yêu cầu mức tối thiểu cao hơn, vì vậy cần xem tài liệu của storage backend để biết chính xác giới hạn kích thước nhỏ nhất.

Làm thế nào để kiểm tra xem PVC đã đầy chưa?

Có thể dùng kubectl get pvc hoặc kubectl describe pvc để xem dung lượng được cấp phát (capacity), nhưng để biết PVC đã sử dụng bao nhiêu, cần kiểm tra bên trong Pod đang mount PVC bằng các lệnh như df -h hoặc du trên đường mount. Ngoài cách thủ công, có thể sử dụng công cụ hỗ trợ như kubectl df-pv, các exporter Prometheus hoặc giải pháp giám sát khác để thu thập metric dung lượng đã dùng và còn trống cho từng PV/PVC trong toàn cluster.

Để đạt được tính sẵn sàng cao cho các ứng dụng stateful, việc kiểm soát lỗi “Volume is already exclusively attached to one node” là điều kiện tiên quyết. Lỗi này là đặc trưng của volume ReadWriteOnce, có thể được giảm thiểu bằng cách phân tích các sự kiện hệ thống. Tuy nhiên, giải pháp bền vững nhất đến từ việc xây dựng một kiến trúc lưu trữ có khả năng tự phục hồi, ngăn chặn xung đột từ giai đoạn thiết kế và đảm bảo hệ thống vận hành không gián đoạn.

THEO DÕI VÀ CẬP NHẬT CHỦ ĐỀ BẠN QUAN TÂM

Đăng ký ngay để nhận những thông tin mới nhất từ blog của chúng tôi. Đừng bỏ lỡ cơ hội truy cập kiến thức và tin tức hàng ngày